AI-Compass Agent智能体技术生态:整合AutoGPT、LangGraph、CrewAI

AI-Compass Agent智能体技术生态:整合AutoGPT、LangGraph、CrewAI等前沿框架,构建自主决策工具调用的AI智能体系统

AI-Compass 致力于构建最全面、最实用、最前沿的AI技术学习和实践生态,通过六大核心模块的系统化组织,为不同层次的学习者和开发者提供从完整学习路径。

- github地址:AI-Compass👈:https://github.com/tingaicompass/AI-Compass

- gitee地址:AI-Compass👈:https://gitee.com/tingaicompass/ai-compass

🌟 如果本项目对您有所帮助,请为我们点亮一颗星!🌟

📋 核心模块架构:

- 🧠 基础知识模块:涵盖AI导航工具、Prompt工程、LLM测评、语言模型、多模态模型等核心理论基础

- ⚙️ 技术框架模块:包含Embedding模型、训练框架、推理部署、评估框架、RLHF等技术栈

- 🚀 应用实践模块:聚焦RAG+workflow、Agent、GraphRAG、MCP+A2A等前沿应用架构

- 🛠️ 产品与工具模块:整合AI应用、AI产品、竞赛资源等实战内容

- 🏢 企业开源模块:汇集华为、腾讯、阿里、百度飞桨、Datawhale等企业级开源资源

- 🌐 社区与平台模块:提供学习平台、技术文章、社区论坛等生态资源

📚 适用人群:

- AI初学者:提供系统化的学习路径和基础知识体系,快速建立AI技术认知框架

- 技术开发者:深度技术资源和工程实践指南,提升AI项目开发和部署能力

- 产品经理:AI产品设计方法论和市场案例分析,掌握AI产品化策略

- 研究人员:前沿技术趋势和学术资源,拓展AI应用研究边界

- 企业团队:完整的AI技术选型和落地方案,加速企业AI转型进程

- 求职者:全面的面试准备资源和项目实战经验,提升AI领域竞争力

Agent模块构建了涵盖25+个前沿框架的智能体技术生态,专注于自主决策、工具调用和任务执行的AI智能体系统。该模块系统性地整理了AutoGPT自主AI智能体、LangGraph状态机智能体、CrewAI协作智能体框架、Microsoft AutoGen多智能体对话、MetaGPT多智能体软件公司等核心技术栈,以及AgentGPT浏览器智能体、BabyAGI任务驱动智能体、SuperAGI开源智能体平台等创新解决方案。

技术特色涵盖了任务规划与分解、工具调用与集成、记忆管理与学习、多智能体协作等核心能力,详细解析了ReAct推理框架、思维链(CoT)、工具学习(Tool Learning)、强化学习优化等关键技术机制。模块深入介绍了智能体架构设计(感知-决策-执行循环)、状态管理机制、工具生态集成(API、数据库、文件系统、网络爬虫)、安全控制策略等工程实践,以及与LLM的深度集成和优化方案。

内容包括代码生成智能体、数据分析智能体、内容创作智能体、客户服务智能体等典型应用场景的架构设计,以及性能监控、错误恢复、资源管理、成本控制等运维实践,帮助开发者构建具备自主学习和决策能力的智能体系统,实现复杂任务的自动化处理和智能化解决方案。

目录

- 0.魔塔agent+LLM/1.agentscope

- 0.魔塔agent+LLM/1.modelscope-agent

- 1.Agent-zero

- 1.Agently

- 1.Camel-Owl

- 1.OpenHands

- 1.OpenManus

- 1.PocketFlow 轻量LLM框架

- 1.Refact-AI-Agent

- 1.SWE-agent

- 1.cooragent

- 2.Agent TARS-字节

- 2.Agent-Squad亚马逊

- 2.AgentGPT

- 2.Agentless

- 2.AutoGPT

- 2.Botpress

- 2.ChatDev

- 2.EvoAgentX

- 2.HuggingGPT

- 2.MetaGPT

- 2.OpenAI Swarm

- 2.Qwen-Agent

- 2.SmolAgent-huggingface

- 2.XAgent

- 2.agentUniverse蚂蚁

- 2.agno

- 2.crewAI

- 2.letta

- 2.mastra

- 2.pr-agent

- 2.pydantic-ai

- 2.微软Autogen+Magentic-One+RD-Agent

- 3.Agenta

- 3.SuperAGI

- 3.atomic-agents

- 3.muAgent-蚂蚁

- 3.superagent

- Agent项目合集+论文

- 3.AGiXT

- 3.AgentBench智谱

- 3.ERNIE Bot

- 3.NVIDIA AgentIQ

- 3.PC-Agent-E上交大+SII推出

- 3.Salesforce MAS Agent框架

- 3.TaskWeaver微软

- 3.babyagi

- 3.core

- 3.gpt-engineer

- 3.gpt-researcher

- 3.ii-agent

- 3.lagent

- 3.minion-agent

- 3.toolkam-Agent

- 3.斯坦福小镇generative_agents

- 4.MobileAgent具身机器人

- 4.UFO-微软面向Windows的Agent框架

- 4.VLN-R1具身智能框架:上海AI lab

Agent项目合集+论文

- e2b-dev/awesome-ai-agents: agent项目合集

- Awesome AI Agents 合集大全

- awesome-ai-agent: AI Agent 领域相关开源资料(openmanus、langmanus、langchain、langgraph、metagpt、magma等),精选文章,分析,产品动态

- awesome-foundation-agents 论文

1.agentscope

简介

AgentScope 是一个面向智能体编程,用于构建大语言模型应用的平台。它具有对开发者透明、支持模型无关开发、“乐高式”智能体构建、面向多智能体、原生分布式/并行化、高度可定制、开发者友好等特点。平台持续更新功能,目前新版本正在开发中。

核心功能

- 智能体构建:支持显式构建用户和助手的对话应用、多智能体对话,提供多种类型智能体,如对话智能体、ReAct 智能体等。

- 工具集成:支持 Tools API,可添加内置工具,连接 MCP Server。

- 结构化输出:使用 Pydantic 的 BaseModel 轻松指定和切换结构化输出。

- 工作流编排:可构建各种类型的智能体工作流,如 Routing、并行化等。

- 分布式与并行化:原生支持分布式智能体应用,支持自动并行化和中心化编排。

- 追踪和监控:提供本地可视化和监控工具 AgentScope Studio,方便追踪工具调用、模型 API 调用和 Token 使用情况。

技术原理

AgentScope 基于面向智能体编程思想,通过模块化设计,将智能体、工具、提示等组件独立开发,开发者可按需组合使用。在模型适配方面,通过统一的接口封装不同 LLM API,实现一次编程适配多种模型。分布式和并行化则借助原生支持的分布式架构和自动并行化机制,提高应用性能。同时,利用钩子函数、Tools API 等技术增强平台的可扩展性和灵活性。

应用场景

-

对话应用开发:构建用户和助手的对话应用,实现多智能体对话。

-

智能工具集成:集成各种工具,如执行 Python 代码、连接 MCP Server 等,为智能体提供更多能力。

-

工作流自动化:编排智能体工作流,实现任务的自动化处理,如路由任务、并行执行任务等。

-

研究与开发:作为研究平台,支持开发者进行智能体编程的研究和实验。

-

agentscope: Start building LLM-empowered multi-agent applications in an easier way.

1.modelscope-agent

简介

ModelScope-Agent是一个可定制且可扩展的Agent框架,旨在连接ModelScope平台中的各种模型与外部世界。它为单个智能体提供了强大的能力,使其能够进行角色扮演、调用大型语言模型(LLM)、使用工具、进行规划和管理记忆,从而实现复杂任务的处理。

核心功能

- 角色扮演 (Role-playing): 智能体可以根据预设的角色或任务需求扮演不同的角色。

- LLM调用 (LLM Calling): 能够与大型语言模型进行交互,利用其强大的生成和理解能力。

- 工具使用 (Tool Usage): 智能体具备调用外部工具和API的能力,扩展其功能边界。

- 规划 (Planning): 能够对复杂任务进行分解和规划,制定执行步骤。

- 记忆 (Memory): 具备记忆功能,可以存储和回顾历史信息,支持上下文理解和持续学习。

- 多智能体协作 (Multi-Agent Collaboration): 支持构建和协调多个智能体共同完成任务。

技术原理

ModelScope-Agent的技术原理核心在于其模块化的Agent架构,通过整合以下关键组件实现智能体能力:

- LLM集成: 作为智能体的“大脑”,提供语言理解、生成和推理的核心能力。

- 工具管理: 实现了工具的注册、调用和结果解析机制,使智能体能与外部系统(如数据API、数据库、特定模型等)交互。

- 规划器 (Planner): 基于任务需求和当前环境,智能体通过规划器生成一系列行动步骤。

- 记忆模块: 用于存储短期和长期信息,包括对话历史、任务进度、工具使用记录等,以便智能体进行上下文理解和决策。

- 统一接口: 提供统一的接口,便于ModelScope内外部模型的集成与调用。

应用场景

- 智能问答与聊天机器人: 构建具备深度理解和复杂交互能力的聊天机器人。

- 数据科学与分析: 自动化数据处理、模型训练和结果分析流程。

- 自动化工作流: 实现跨多个系统和工具的自动化任务执行。

- 代码生成与开发辅助: 辅助开发者进行代码编写、调试和优化。

- 智能体系统构建: 搭建具备自主学习和决策能力的多智能体协作系统。

- 个性化推荐系统: 基于用户行为和偏好进行智能推荐。

- 移动应用开发: 集成AI能力到Android等移动应用中。

- modelscope/modelscope-agent: ModelScope-Agent: An agent framework connecting models in ModelScope with the world

- modelscope/modelscope-agent: ModelScope-Agent: An agent framework connecting models in ModelScope with the world

- modelscope-agent/README_CN.md at master · modelscope/modelscope-agent

1.魔塔-demo

魔塔agent应用文档

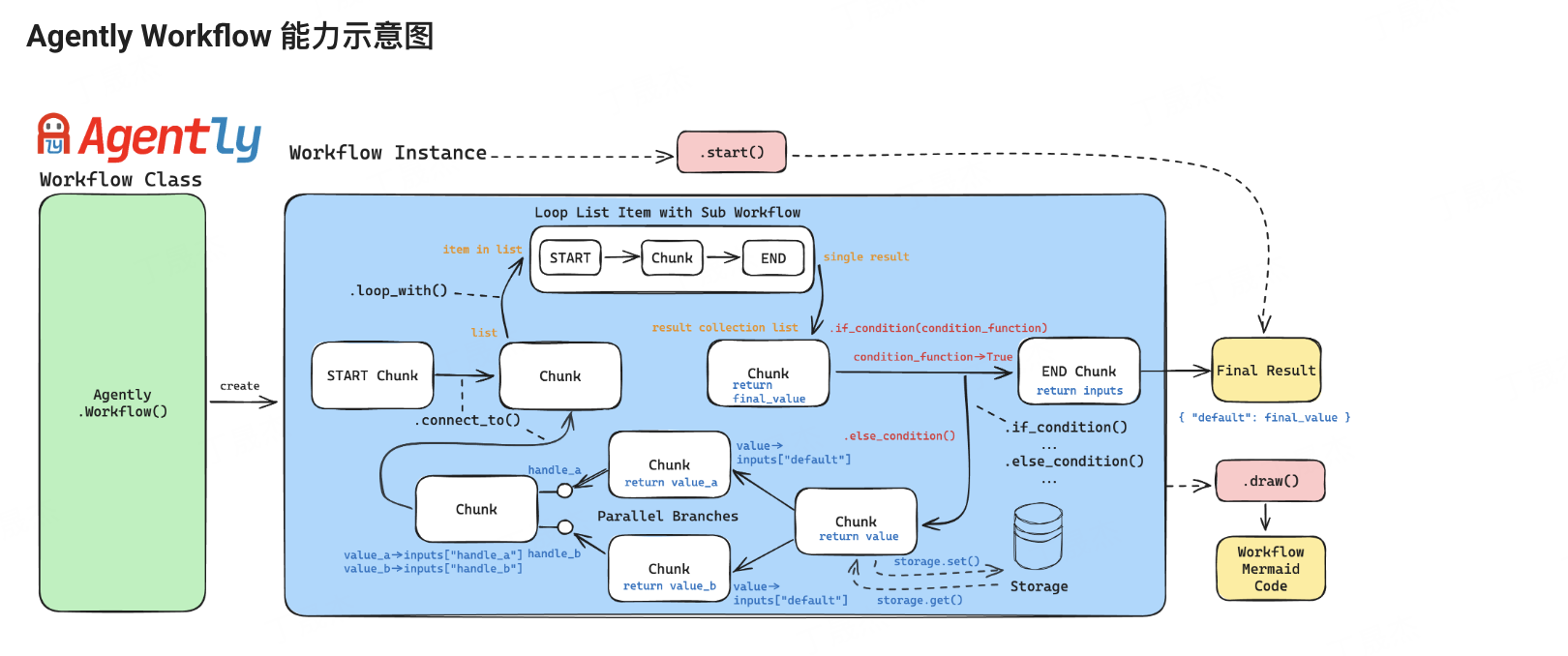

1.Agently

简介

Agently是一个开源的AI Agent原生应用开发框架,具有快速开始、表达轻松、插件增强、开源开放等特点。它适配多种模型,提供丰富的请求指令和功能,可用于构建不同领域的Agent示例,支持多轮对话及运行时数据管理。

核心功能

- 模型适配:支持OpenAI GPT、Google Gemini、百度文心一言、智谱GLM等多种商用模型API,方便开发者切换模型。

- 请求指令丰富:提供基础请求指令,如

.general()、.role()、.input()等,可灵活构造请求。 - 结构化输出:通过Output输出结构表达语法格式,可获得对应结构的生成结果。

- 高级Prompt构造:支持行动流提示、分支逻辑判断、自我批判修正、确保关键信息纯净度等高级技巧。

- 流式输出与事件监听:大部分适配模型支持流式输出,可通过事件监听处理器接收和处理流式数据。

- 多轮对话管理:通过Session能力增强插件,自动持续记录会话消息列,支持多轮对话。

- 运行时数据管理:管理主要请求运行时数据、Agent实例运行时数据及其长时固化存储。

技术原理

- 模型适配原理:框架通过封装不同模型的API请求方式,实现业务流程代码和模型适配之间的依赖解耦,开发者可按说明配置并放心切换模型。

- 请求处理原理:将Agent实例与模型的一次主要请求交互视作原子节点,通过

.start()命令触发,多个原子节点可串联。在请求过程中,会根据指令将数据存储到运行时数据中,经框架核心逻辑整理后发起模型请求。 - 流式输出原理:框架在请求逻辑中对流式输出的数据块进行清洗,通过

response:delta事件抛出仅包含增量文本块的数据,开发者可通过事件监听处理器接收和处理。 - 运行时数据管理原理:Agent实例运行时数据分为主要请求运行时数据、Agent实例运行时数据及其长时固化存储,不同类型数据有不同的生命周期和管理方式,通过插件对运行时数据进行交互和管理。

应用场景

- 信息查询与解答:如根据自然语言生成SQL的提数小帮手Agent、自带搜索技能的少儿教师Agent等,可帮助用户查询信息并解答问题。

- 营销文案生成:根据图片以及文案样例生成广告文案的营销Agent,满足营销场景需求。

- 角色扮演:根据用户简单输入,自动创建人设,并能够在多个状态间切换的角色扮演Agent,用于角色扮演游戏等场景。

- 多轮对话交互:在聊天机器人、智能客服等场景中,支持多轮对话,结合用户历史对话记录提供更精准的回复。

- 代码开发辅助:在代码逻辑中寻求Agent的支持,如基于长文本生成问答对、让Agent完成仅有注释的函数指定的任务等。

- 游戏场景应用:为游戏中的NPC提供行动选项和演出台词,增强游戏的交互性和趣味性。

- Agently AI应用开发框架

- AgentEra/Agently: [GenAI Application Development Framework] 🚀 Build GenAI application quick and easy 💬 Easy to interact with GenAI agent in code using structure data and chained-calls syntax 🧩 Use Agently Workflow to manage complex GenAI working logic 🔀 Switch to any model without rewrite application code

- 【开发教程】Agently AI Agent原生应用开发框架Show Case - 飞桨AI Studio星河社区

- 手把手入门教程 - Agently AI应用开发框架

Agently案例大全

包括Agently项目的playground、SQL生成器示例;Agently Daily News Collector项目,这是一个基于大语言模型(LLM)的自动每日新闻收集工作流展示项目;以及translation-agent项目,它是使用Agently开发框架实现的单块翻译工作流的复制品,具备可轻松切换模型、清晰表达工作流、可编辑提示文件优化指令等特点。

- 案例大全Agently/playground

- SQL生成:基于给定的数据库元数据信息,根据自然语言输入生成查询SQL

- 全自动高质量新闻汇总报告生成器:分栏目检索、整理、汇总并撰写推荐语

- 新闻汇总报告生成器AgentEra/Agently-Daily-News-Collector: An open-source LLM based automatically daily news collecting workflow showcase powered by Agently AI application development framework.

- 翻译工作流项目

Agently飞桨案例支持

这些项目主要基于Agently框架展开,涉及多个不同应用领域。有利用Agently和ERNIE模型结合SunoV3音乐生成,为用户提供创作国庆主题歌曲的平台;有借助Agently实现历史类问题的智能问答、问题库生成及趣味问答游戏;还有基于Agently框架搭载文心大模型,构建游戏IP孵化平台,可快速生成并定制游戏角色。

- 快来用Agently设定属于你的游戏IP - 飞桨AI Studio星河社区

- 【趣味项目】基于文心大模型的AI陪玩诗牌游戏 - 飞桨AI Studio星河社区

- 你的专属Agently的皮肤问题咨询助手 - 飞桨AI Studio星河社区

- 打造你的AI小伙伴!不满意?找Agently大法师来施魔法 - 飞桨AI Studio星河社区

- 基于Agently的访谈式分类器——以哈利波特分院帽为例 - 飞桨AI Studio星河社区

- 基于文心和Agently的英语提升助手 - 飞桨AI Studio星河社区

- 【国韵新声】基于Agently和SunoAI智能谱写国庆辉煌乐章 - 飞桨AI Studio星河社区

- 【智史引擎】基于Agently工作流的历史智慧问答助手 - 飞桨AI Studio星河社区

- 【月满华章】基于Agently的中秋节文化探索与智慧互动平台 - 飞桨AI Studio星河社区

- 【开发教程】Agently AI Agent原生应用开发框架Show Case - 飞桨AI Studio星河社区

- 【国韵新声】基于Agently和SunoAI智能谱写国庆辉煌乐章 - 飞桨AI Studio星河社区

- 【月满华章】基于Agently的中秋节文化探索与智慧互动平台 - 飞桨AI Studio星河社区

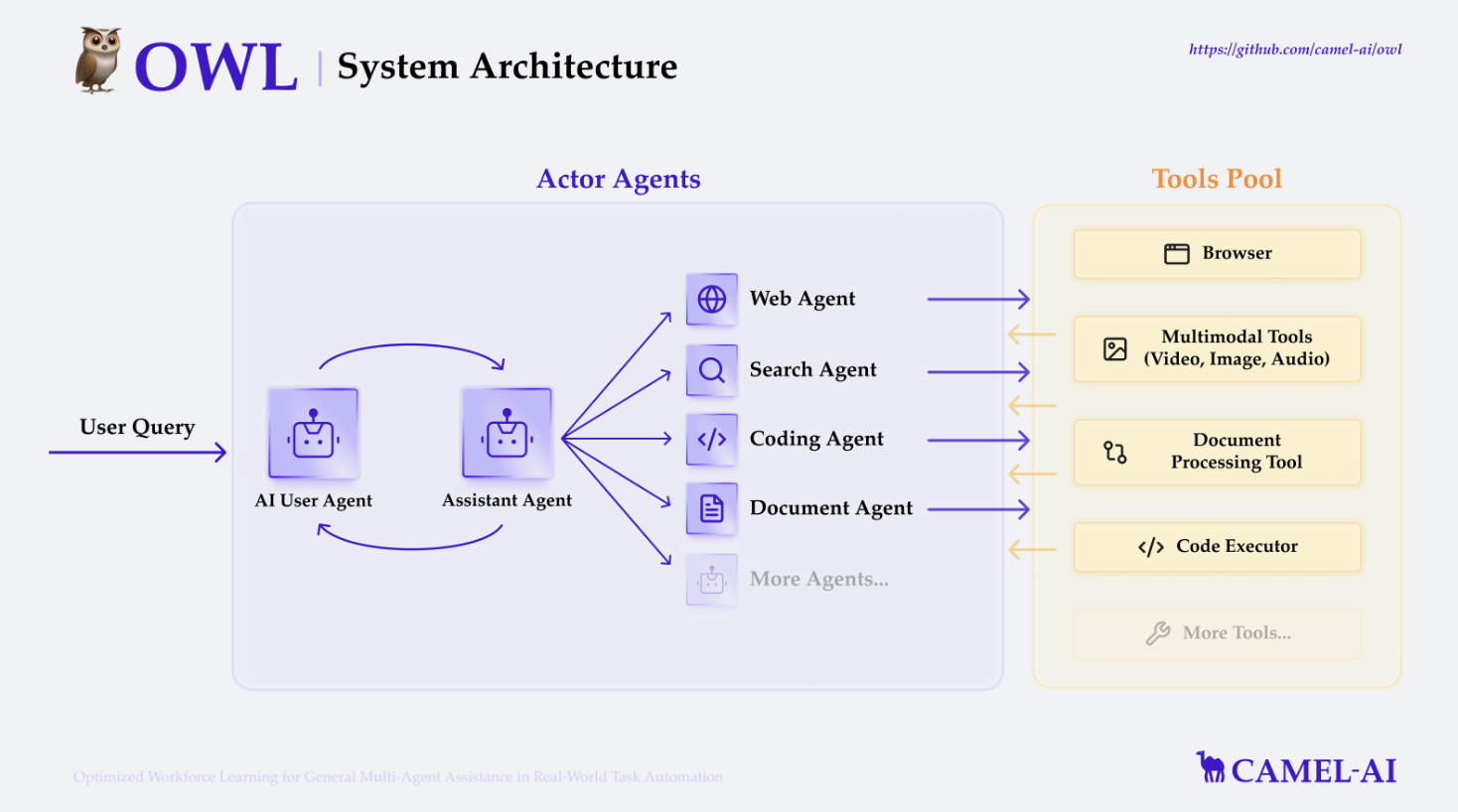

1.Camel-Owl

简介

CAMEL - AI是一个致力于探索智能体缩放定律的开源社区,开发了世界首个多智能体系统框架。旗下的OWL框架基于CAMEL - AI构建,是前沿的多智能体协作框架,可推动任务自动化。CAMEL - AI旨在通过大规模研究智能体,深入了解其行为、能力和潜在风险,支持多种类型的智能体、任务、提示、模型和模拟环境。

核心功能

- 数据生成:实现思维链(CoT)数据生成、自指令(Self - Instruct)指令生成、源到合成(Source2Synth)多跳问答生成等,生成高质量数据。

- 任务自动化:通过角色扮演和多智能体协作的工作流(Workforce)解决任务,利用检索增强生成(RAG)管道提升自动化效率。

- 世界模拟:如OASIS可模拟百万级智能体的社交互动,研究复杂社会现象。

- 多工具集成:支持在线搜索、多模态处理、浏览器自动化、文档解析、代码执行等,拥有丰富的工具包。

技术原理

- 可进化性:多智能体系统通过生成数据和与环境交互不断进化,可由强化学习或监督学习驱动。

- 可扩展性:设计支持数百万智能体的系统,确保大规模下的高效协调、通信和资源管理。

- 状态性:智能体维护有状态的内存,便于进行多步交互和处理复杂任务。

- 代码即提示:代码和注释作为智能体的提示,要求编写清晰可读。

应用场景

-

科研领域:研究智能体的行为、能力和潜在风险,探索多智能体系统的前沿研究。

-

数据生成:为模型训练生成高质量的合成数据。

-

任务自动化:实现各种任务的自动化处理,如股票价格查询、代码调试等。

-

世界模拟:模拟社交平台上的用户行为,研究信息传播、群体极化等社会现象。

-

Welcome to CAMEL’s documentation! — CAMEL 0.2.43 documentation

1.OpenHands

简介

OpenHands 是 All Hands AI 推出的一个开源人工智能软件开发智能代理项目,前身为 OpenDevin,旨在提供一个 Devin 的开源替代方案。它通过直观简洁的交互界面,允许用户使用自然语言执行各种软件开发任务,致力于“少写代码,多出成果”(Code Less, Make More)。该项目在 GitHub 上拥有庞大的社区和贡献者,并遵循 MIT 许可证,强调代理技术应开放而非被少数公司控制。

核心功能

- 自然语言交互式开发: 用户可以通过自然语言指令进行项目克隆、代码修改、命令执行、API 调用和代码提交等软件开发任务。

- 全栈开发自动化: 具备从问题理解到代码实现、测试、部署等全生命周期的自动化能力。

- 基准性能卓越: 在 SWE-bench、多语言 Multi-SWE-bench 以及无污染的 LiveSWEBench 等多种软件开发代理基准测试中表现出色。

- 多语言和环境支持: 支持跨8种编程语言进行开发任务。

- 高度兼容性: 兼容多种大型语言模型(LLM)提供商。

技术原理

OpenHands 的核心技术原理是基于人工智能驱动的智能代理(AI-powered intelligent agent)。它利用大型语言模型(LLMs)的强大自然语言理解和生成能力,将用户的自然语言指令转化为可执行的软件开发操作。通过与开发环境(如终端、代码编辑器、版本控制系统)的深度集成,该代理能够模拟人类开发者的行为,执行代码生成、调试、测试和部署等复杂任务。其设计理念强调模块化和可扩展性,支持不同 LLM 的接入,并能够理解和响应来自不同编程语言的需求,实现自动化工作流。

应用场景

- 自动化软件开发: 协助或自动完成重复性、繁琐的编码、调试和测试任务,提升开发效率。

- 开发者辅助工具: 作为个人开发者的智能助手,快速生成代码片段、解决编程问题或执行环境配置。

- DevOps流程优化: 自动化CI/CD流程中的代码检查、部署和维护环节。

- 教育与研究: 作为学习和研究AI代理在软件工程领域应用的平台,探索未来软件开发模式。

- 跨语言开发: 帮助开发者在不熟悉特定编程语言的情况下,完成代码修改或功能实现。

1.OpenManus

简介

OpenManus是由MetaGPT团队开发的开源项目,可在无邀请码情况下实现各种想法。同时,OpenManus - RL由UIUC和OpenManus的研究人员合作开发,致力于基于强化学习(如GRPO)的大语言模型(LLM)智能体调优方法,会公开探索方向和结果,欢迎社区贡献。

核心功能

- 模型调优:提供基于强化学习的调优方法,如GRPO、PPO等,用于定制智能体行为。

- 数据收集:连接专业推理模型收集智能体轨迹数据。

- 基准测试:在多个智能体基准测试上评估框架性能。

技术原理

- 推理模型:评估GPT - O1、Deepseek - R1、QwQ - 32B等模型,为下游优化和训练提供依据。

- 策略探索:采用树状思维、图状思维、深度优先搜索决策树、蒙特卡罗树搜索等策略增强规划效率和推理鲁棒性。

- 奖励建模:训练智能体奖励模型,使用基于格式和结果的奖励策略。

- 集成框架:集成Verl、TinyZero等强化学习调优框架。

应用场景

-

智能问答:处理多任务问答和思维链推理。

-

对话交互:实现工具增强的对话。

-

电商购物:在WebShop等电商环境中进行测试和应用。

-

OpenManus/OpenManus-RL: A live stream development of RL tunning for LLM agents

-

mannaandpoem/OpenManus: No fortress, purely open ground. OpenManus is Coming.

Langmanus

简介

LangManus 是一个社区驱动的 AI 自动化框架,基于开源社区构建,旨在将语言模型与网页搜索、爬虫和 Python 代码执行等专业工具结合,实现复杂任务自动化。

核心功能

- LLM 集成:支持 Qwen 等开源模型,具备 OpenAI 兼容 API 接口和多层级 LLM 系统。

- 搜索与检索:通过 Tavily API 进行网页搜索,结合 Jina 实现神经搜索和高级内容提取。

- Python 集成:内置 Python REPL 和代码执行环境,支持包管理。

- 工作流管理:提供工作流图可视化、多智能体编排、任务委派和监控功能。

技术原理

LangManus 实现了分层多智能体系统,由协调器、规划器、监督器等多个智能体协作完成任务。系统采用模板引擎处理智能体提示,根据不同任务类型调用不同的语言模型,并通过配置环境变量进行定制。

1.PocketFlow 轻量LLM框架

简介

PocketFlow是一个仅100行代码的轻量级大语言模型(LLM)框架,具有零依赖、无供应商锁定的特点。它以图为核心抽象,可实现如(多)智能体、工作流、检索增强生成(RAG)等流行设计模式,支持通过智能体编码范式开发复杂的LLM应用。

核心功能

- 轻量级实现:仅100行代码,包含LLM框架核心抽象,避免冗余。

- 多样设计模式支持:支持(多)智能体、工作流、RAG、Map Reduce等设计模式。

- 智能体编码:便于AI智能体协助人类构建复杂LLM应用。

- 节点与流程管理:通过节点处理简单任务,流程连接节点,共享存储实现节点间通信。

技术原理

PocketFlow将LLM工作流建模为图和共享存储的组合。其中,节点负责处理简单的LLM任务,流程通过动作(有标签的边)连接节点,共享存储用于节点间通信。在此基础上,可实现多种设计模式,且不提供内置实用工具,避免供应商特定API的硬编码,提高灵活性和可维护性。

应用场景

-

聊天机器人开发:如网站聊天机器人,实现24/7客户支持。

-

内容处理:如YouTube视频总结、简历结构化数据提取。

-

代码生成与优化:生成测试用例、实现解决方案并迭代改进代码。

-

智能决策辅助:如研究智能体,可搜索网络并回答问题。

-

The-Pocket/PocketFlow: Pocket Flow: 100-line LLM framework. Let Agents build Agents!

PocketFlow一些讲解

主要围绕PocketFlow展开,它是一个仅100行代码实现的LLM框架,旨在解决现有LLM框架臃肿、依赖项多等问题。介绍了其核心概念Node、Flow与Shared Store,还给出了多个实践示例,如问答、聊天、旅行顾问聊天及Web Search Agent等,虽易用性不足,但灵活性高。

- 详解:PocketFlow这个极简的AI工作流开发框架? - 知乎

- “Pocket Flow,一个仅用 100 行代码实现的 LLM 框架” - 知乎

- 使用PocketFlow构建Web Search Agent - 知乎

1.Refact-AI-Agent

简介

Refact.ai 是一款开源的 AI 软件工程智能体 (AI Agent),旨在作为 GitHub Copilot 的替代方案。它能够端到端地处理工程任务,深入理解代码库,并与开发者的工具、数据库和浏览器集成,以自动化复杂的多步骤任务,从而提升开发效率和代码质量。

核心功能

- 代码自动补全与生成: 提供上下文感知的代码建议和自动补全。

- 代码分析与重构: 执行代码分析,识别潜在问题,并支持代码重构。

- 错误与缺陷修复: 辅助识别并修复代码中的错误和缺陷。

- 端到端工程任务自动化: 能够规划、执行并迭代复杂的软件工程任务。

- 工作流适应性: 适应开发者的工作流程,提供即时协助。

- 多工具集成: 与开发工具、数据库和浏览器无缝集成。

技术原理

Refact.ai 的核心基于先进的 AI Agent 架构,该架构可能利用了大型语言模型 (LLMs) 对代码的深层语义理解能力。其技术原理包括:

- 代码语义理解: 通过训练在海量代码数据上的模型,实现对代码逻辑、结构和上下文的深度解析。

- 多模态感知: 能够追踪光标位置,感知用户当前的工作状态和意图。

- 任务规划与执行: 采用 AI Agent 范式,能够将复杂工程任务分解为可执行的子任务,并进行规划、执行及结果验证。

- 集成与交互层: 构建了与各类开发工具 (如 VS Code, JetBrains)、数据库和浏览器进行数据交换和操作的接口层。

- 自适应学习: 可能包含持续学习机制,以适应特定代码库和开发者的编码习惯,提供更个性化的协助。

应用场景

- 软件开发与编程: 作为开发者的智能副驾驶,提供代码自动补全、错误检查和代码生成。

- 代码审查与质量保证: 辅助进行代码分析,提升代码质量,减少人工审查负担。

- 自动化测试与调试: 辅助生成测试用例,识别并修复程序错误。

- 遗留代码维护: 帮助开发者快速理解和修改现有复杂或陌生的代码库。

- 工程任务自动化: 自动化如重构大型代码块、实现特定功能模块等端到端的工程任务。

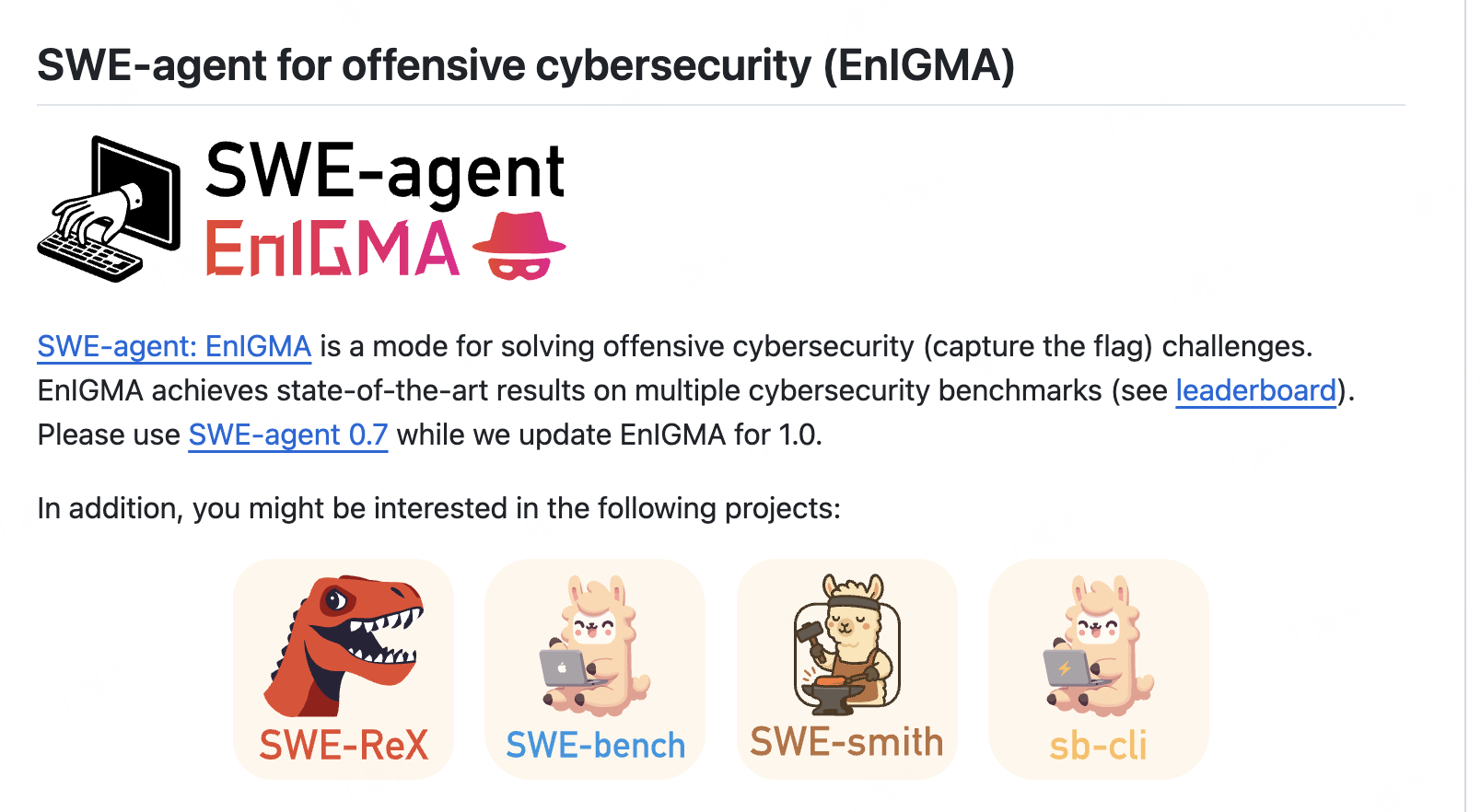

1.SWE-agent

简介

SWE-agent是由普林斯顿大学研究团队开发的一个开源AI软件工程代理工具。它旨在利用大型语言模型(如GPT-4)的能力,自动接收GitHub上的问题报告(issue),并尝试自主修复代码,最终生成拉取请求(pull request)。该项目在提高软件开发效率方面展现了显著潜力。

核心功能

- 自动问题修复: 接收GitHub issue,并自动化地识别、分析和修复代码中的错误。

- 生成拉取请求: 在修复完成后,自动创建并提交包含修复代码的拉取请求。

- 高效性能: 在SWE-bench评估数据集上,能够以高效率(例如,在1分钟内解决部分问题)解决GitHub issue,达到了领域内的最新水平(State-of-the-Art)。

- 网络安全应用: 可用于攻击性网络安全或竞争性编程挑战,例如EnIGMA项目已在多个网络安全基准测试中取得先进结果。

技术原理

SWE-agent的核心技术原理是利用**大型语言模型(LLM)**作为其智能驱动。它赋予LLM自主操作和与代码库、开发环境交互的能力。

- 任务理解与规划: LLM接收GitHub issue的描述,并通过其自然语言理解能力解析问题,并制定修复问题的策略和步骤。

- 代码库交互: 代理能够在代码库中导航、阅读、编辑文件,并执行测试、编译等操作,这通常涉及到与文件系统和命令行工具的交互。

- 自主代理执行: LLM作为控制器,驱动代理在环境中执行一系列编程动作,如代码修改、调试、测试运行等,直到问题被解决。

- 结果验证与反馈: 代理会运行测试用例来验证修复的正确性。如果测试失败,LLM可能会重新评估并调整修复策略,形成一个迭代的反馈循环。

- 模型选择: 支持使用GPT-4或其他多种大型语言模型作为后端,提供了灵活性和可扩展性。

应用场景

- 自动化软件维护: 自动处理开源项目或企业内部项目中的日常bug报告和小型功能请求,减轻开发人员负担。

- 持续集成/持续部署 (CI/CD) 流程增强: 作为CI/CD流程的一部分,自动识别并修复引入的回归错误,提高开发效率和代码质量。

- 网络安全渗透测试: 用于自动化地发现和修复代码中的安全漏洞(如EnIGMA项目所示)。

- 编程教育与辅助: 作为编程学习工具,帮助学生理解和解决代码问题。

- 竞争性编程: 辅助参与竞争性编程挑战,快速解决编程难题。

1.cooragent

简介

Cooragent是一个AI智能体协作社区,支持用户用一句话创建强大的智能体,并与其他智能体协作完成复杂任务。它有两种任务模式(智能体工厂和智能体工作流)和三种工作流模式(启动、优化、生产),还提供CLI工具,方便开发者快速构建、编辑和删除智能体。

核心功能

- 自动创建智能体:在智能体工厂模式下,根据用户描述生成智能体;在智能体工作流模式下,自动分析任务并选择合适智能体协作。

- 高效构建工作流:提供三种工作流模式,自动分析需求、选择智能体和构建工作流,用户可手动或用自然语言命令优化。

- CLI工具支持:开发者可通过CLI工具快速创建、编辑、删除智能体,使用一组智能体协作完成复杂任务。

- 集成MCP服务:通过模型上下文协议(MCP)集成外部服务和工具,增强智能体功能。

技术原理

- 系统通过Planner模块,在智能体构建时根据用户需求选择合适工具、自动打磨Prompt;在工作流构建中结合智能体专长规划任务步骤和顺序。利用APE和Absolute - Zero - Reasoner等框架,根据用户自然语言命令调整智能体的Prompt、工具等操作参数。

应用场景

- 股票分析:创建股票分析专家智能体,分析股票趋势、预测股价并提供买卖建议。

- 旅行规划:使用多个智能体协作,完成旅行规划、信息获取、报告生成和文件保存等任务。

- 导航规划:创建导航智能体,利用地图工具规划路线。

1.agent-zero

简介

Agent Zero (A0) 是一个自进化、工具构建型的AI框架,旨在成为一个透明、易读、可理解、可定制和交互式的AI工具。它不同于预先定义的AI系统,能够随着用户的使用而有机地成长和学习。作为一个下一代AI助手,Agent Zero被设计为免费、开源且完全可定制,旨在将无限的AI能力带给所有人。

核心功能

- 自适应进化与学习: Agent Zero的核心能力在于其能够随着使用而自主进化和学习,不断适应和增强自身功能。

- 工具构建与集成: 该框架支持AI自主构建和工程化自身的能力,实现工具的创建与集成。

- 任务执行: 能够利用用户的电脑资源来执行并完成各种指定的任务。

- 高度可定制性: 提供全面的定制能力,允许用户根据具体需求调整和塑造AI行为。

- 交互式操作: 提供直观的交互界面,使用户能够轻松地与AI进行互动和指导。

技术原理

Agent Zero的实现可能基于以下技术原理:

- 自修改与自适应算法: 采用先进的AI算法,使其能够根据运行时数据和用户反馈动态修改自身行为和学习模型,实现能力的迭代优化。

- 元学习(Meta-Learning)/终身学习: 可能集成元学习或终身学习机制,使AI能够从过往经验中学习如何学习,从而加速新任务的适应和知识积累。

- 虚拟化与沙盒环境: 作为在“自身虚拟计算机”中运行的AI助手,可能利用虚拟化或沙盒技术,提供一个隔离且安全的执行环境,便于管理和控制AI的行为。

- 动态工具注册与调用: 具备识别、学习并动态调用外部工具或内部模块的能力,以扩展其解决问题的范畴。

- 可解释AI(XAI)设计: 强调透明、易读和可理解性,可能在架构中融入可解释AI的设计原则,提供决策过程的洞察。

应用场景

- 个性化智能助理: 作为高度可定制的AI助手,可根据个人或企业需求提供专属的自动化服务和任务执行。

- 自动化工作流程: 在办公自动化、数据处理、软件开发等领域,实现复杂任务的自动化和优化。

- 教育与研究: 作为一个透明和可理解的AI框架,可用于AI教育、实验和研究,帮助开发者和研究人员深入理解AI的运作机制。

- AI能力扩展与集成: 为开发者提供一个平台,快速构建、部署和货币化AI代理,扩展现有系统的AI能力。

- 本地化AI解决方案: 由于其强调利用本地计算机资源执行任务,适用于需要离线或本地部署的AI解决方案,保护数据隐私。

2.Agent TARS-字节

简介

Agent TARS 是一个开源的多模态智能体,旨在通过视觉解释网页、无缝集成命令行和文件系统来革新 GUI 交互。该项目提供了快速启动指南,包括环境设置、模型和搜索提供商配置等步骤,同时支持人机交互和任务共享。UI-TARS-desktop 是基于 UI-TARS(视觉语言模型)的 GUI 智能体应用程序,于 2025 年 4 月 17 日发布了 v0.1.0 版本,重新设计了智能体 UI。

核心功能

- 多模态交互:通过视觉解释网页,实现与命令行和文件系统的无缝集成。

- 任务执行:根据用户输入的指令完成规划、搜索、分析和报告生成等任务。

- 人机交互:支持在任务执行过程中通过输入框与智能体进行交互。

- 任务共享:支持将任务线程以本地 HTML 文件或远程服务器 URL 的形式共享给他人。

技术原理

Agent TARS 通过多模态感知技术视觉解释网页,利用自然语言处理技术理解用户指令并进行任务规划。它通过 MCP 与浏览器连接,实现对网页的操作和数据获取。同时,它支持多种模型和搜索提供商,用户可以根据需求进行配置和测试。

应用场景

-

信息检索与分析:帮助用户快速获取和分析网页上的信息,如获取 ProductHunt 上最受欢迎的项目并进行深入分析。

-

报告生成:根据用户的需求生成详细的研究报告。

-

人机协作:在任务执行过程中,用户可以随时干预和调整智能体的工作方向。

-

知识共享:用户可以将完成的任务线程分享给他人,促进知识交流和协作。

2.Agent-Squad亚马逊

简介

Agent Squad(原名Multi-Agent Orchestrator)是由AWS Labs开发的一款灵活、轻量级开源框架,旨在管理和协调多个AI智能体,以处理和优化复杂的对话及任务。它提供了一套强大的工具,用于编排不同类型的AI智能体,实现智能路由和上下文维护,从而构建高效、协同的AI解决方案。

核心功能

- 多智能体编排与管理: 灵活、轻量级地协调和管理多个AI智能体,支持不同类型智能体的集成。

- 智能查询路由与上下文维护: 能够智能地路由用户查询,并在整个交互过程中维护对话上下文,确保连贯性。

- 团队协作(SupervisorAgent): 引入SupervisorAgent,实现多专业智能体之间的复杂团队协调,支持“智能体即工具”架构,允许主导智能体并行协调团队。

- 预构建组件与定制化: 提供预构建组件以实现快速部署,同时支持轻松集成自定义智能体和对话消息存储解决方案。

- 与AWS Bedrock等服务的集成: 可与AWS Bedrock的LLM代理(支持Converse API)和Lex Bot代理等服务集成,展示了其广泛的兼容性。

技术原理

Agent Squad 的核心技术原理在于其多智能体编排(Multi-Agent Orchestration)架构。它通过实现智能路由算法来分配和引导用户请求到最合适的AI智能体,确保高效处理。上下文管理机制是其关键组成部分,允许系统在跨多个智能体和交互中保持对话的连贯性和历史信息。

此外,该框架引入了SupervisorAgent,它遵循一种**“智能体即工具”(Agent-as-Tools)的设计范式。在这种范式下,主导智能体能够将复杂的任务分解,并将子任务委托给其他专业智能体并行执行,最终整合结果。这种架构促进了模块化和协同工作**,使得复杂的AI应用能够通过组合不同的AI能力来实现。框架还支持与Amazon Bedrock等云服务中的大型语言模型(LLM)代理和Lex Bot等服务进行API集成,利用其强大的对话和生成能力。

应用场景

- 复杂客户服务与支持: 处理多轮、复杂的用户咨询,通过协调不同专业客服智能体(如产品查询、技术支持、订单管理)提供全面解决方案。

- 智能助理与对话系统: 构建能够处理多领域请求的智能助理,例如日程管理、信息检索和任务执行,通过不同智能体分工协作。

- 企业内部流程自动化: 自动化涉及多个部门或系统的复杂工作流程,例如通过协调审批、数据录入和报告生成智能体来加速业务流程。

- 教育与培训: 创建交互式学习平台,其中不同的智能体可以提供定制化的教学内容、答疑解惑和进度评估。

- 研发与知识管理: 辅助科研人员进行文献检索、数据分析和报告撰写,通过协调专注于不同研究领域的智能体来加速知识发现和管理。

- awslabs/agent-squad: Flexible and powerful framework for managing multiple AI agents and handling complex conversations

- awslabs.github.io

2.AgentGPT

简介

AgentGPT 是一个可在浏览器中配置和部署自主 AI 代理的工具。用户能自定义 AI 名称并为其设定目标,AI 会思考任务、执行任务并从结果中学习以达成目标。

核心功能

- 配置和部署自主 AI 代理。

- 允许用户自定义 AI 名称并设定目标。

- AI 可自主思考任务、执行任务并从结果中学习。

技术原理

采用 create - t3 - app + FastAPI - template 进行引导,运用 Nextjs 13 + Typescript + FastAPI 框架,借助 Next - Auth.js 进行身份验证,使用 Prisma 与 SQLModel 作为 ORM,以 Planetscale 为数据库,利用 TailwindCSS + HeadlessUI 进行样式设计,通过 Zod + Pydantic 进行模式验证,采用 Langchain 作为大语言模型工具。

应用场景

适用于需要自主 AI 代理执行特定任务、达成特定目标的场景,如自动化数据处理、信息收集等。

2.Agentless

简介

OpenAutoCoder-Agentless 是一种创新的、无需代理(Agentless)的方法,旨在自动化解决软件开发问题。它通过简化的三阶段流程来处理每个问题,旨在提高效率并降低成本。根据LinkedIn上的介绍,它能够以大约0.34美元的成本解决SWE-bench Lite上27.3%的GitHub问题。

核心功能

- 自动化问题解决: 核心功能是自动识别并解决软件开发中遇到的问题,包括GitHub上的各类issue。

- 三阶段处理流程: 采用一套简洁的三阶段流程来系统性地解决问题,提高了自动化解决的效率和准确性。

技术原理

Agentless 的技术核心在于其“无代理”架构,这意味着它可能不依赖于传统的、需要迭代和多步交互的AI代理模式,而是通过更直接、高效的算法或模型来处理问题。虽然具体细节未完全披露,但其能解决SWE-bench Lite上的问题,暗示了其可能集成了代码理解、错误诊断、代码生成/修改以及自动化测试验证的能力。这种方法可能侧重于一次性或少数次迭代的解决方案生成,以降低资源消耗并加速问题解决过程。

应用场景

- 自动化软件维护: 可用于自动修复软件bug,处理GitHub等平台上的issue。

- 提高开发效率: 协助开发者自动完成部分重复性或标准化的编码任务。

- 降低研发成本: 通过自动化解决问题,减少人工干预和资源投入。

- 教育与研究: 作为自动化软件工程工具的实践案例或研究平台。

2.AutoGPT

简介

主要介绍了AutoGPT和AutoGen相关内容。AutoGPT是强大的平台,可创建、部署和管理连续AI智能体,实现复杂工作流自动化,有前端和服务器,具备多种功能;AutoGen提供通用多智能体对话框架,能创建可定制、可对话的智能体,集成大语言模型、工具和人类,实现多智能体聊天自动化。

核心功能

- AutoGPT:提供前端界面,有智能体构建器、工作流管理、部署控制等功能;服务器包含源码、基础设施和市场;有预配置智能体库,支持监控和分析。

- AutoGen:提供多智能体对话框架,创建可定制、可对话智能体,实现多智能体聊天自动化,支持结合工具执行任务。

技术原理

- AutoGPT:前端通过低代码界面设计智能体,以连接块方式构建工作流;服务器提供核心逻辑和基础设施支持智能体运行。采用Docker等技术,遵循一定网络和软件要求保障运行。

- AutoGen:运用通用多智能体对话框架,集成大语言模型、工具和人类,实现智能体间的自动化聊天和任务执行。

应用场景

-

AutoGPT:生成热门话题视频、识别视频中的热门引语用于社交媒体发布,可定制工作流以满足不同场景。

-

AutoGen:适用于需要多智能体协作完成的任务,可结合工具实现自动化操作,能在有人类反馈或自主情况下完成工作。

2.Botpress

简介

Botpress是一个用于构建由最新大语言模型(LLM)驱动的人工智能代理的一体化平台,以开源的方式为开发者提供支持,可帮助用户快速为项目或企业构建出色的聊天机器人和助手。其仓库包含集成、开发工具、示例机器人和插件等内容,社区可参与贡献。

核心功能

- 客户支持增强:协助处理常规咨询,必要时进行问题升级,保持各渠道服务的一致性。

- 多平台部署:支持在Slack、WhatsApp、Facebook Messenger等平台部署。

- 系统集成:通过API接入业务数据,处理文件、表格和用户记录等结构化输入。

- 上下文对话:实现有状态和持久化的对话,支持跨步骤跟踪上下文。

- 自定义开发:允许注入自定义代码,可对代理的操作和执行进行全面监控。

技术原理

Botpress的核心是自定义推理引擎LLMz,负责协调代理行为,包括解释指令、管理内存、选择工具、执行代码和返回响应。采用完全隔离的运行时架构,每个部署的代理都有独立的运行环境,版本化、持久化且与未来平台变更兼容。

应用场景

-

客户服务:处理常见问题咨询、退款申请、添加卡片等业务流程。

-

内容生成:如生成文章、图像等。

-

音频处理:对音频进行转录等操作。

-

办公自动化:辅助完成创建问题、添加卡片等任务。

-

botpress/botpress: The open-source hub to build & deploy GPT/LLM Agents ⚡️

2.ChatDev

简介

ChatDev是一种借助自然语言创意创建定制化软件的平台。OpenBMB的ChatDev是虚拟软件公司,通过不同智能代理协作,提供基于大语言模型的易使用、可定制和扩展的框架;10cl的ChatDev IDE则是构建AI代理的工具,支持多种大语言模型,具有PromptIDE等功能,可用于游戏NPC定制等。

核心功能

- OpenBMB的ChatDev:多智能代理协作进行软件开发,包括需求分析、编码、测试和文档编写;支持增量开发、Git模式、人机交互模式和艺术模式;可自定义软件开发流程、阶段和角色。

- 10cl的ChatDev IDE:加速提示工程,支持JavaScript实现复杂提示技术;具有游戏模式可定制NPC和位置标记;支持从代理社区导入或自定义代理;PromptIDE具备自动完成、双屏显示、可视化提示流等功能。

技术原理

- OpenBMB的ChatDev:基于大语言模型,通过多智能代理组织架构协作,各代理参与专业功能研讨会完成软件开发任务。

- 10cl的ChatDev IDE:通过JavaScript支持实现复杂提示技术,利用PromptFlow将LLM、提示、JavaScript代码和其他工具连接成有向无环图(DAG)进行开发。

应用场景

-

软件开发:快速开发定制化软件,如游戏、工具类软件等。

-

游戏开发:定制游戏中的NPC,实现更丰富的游戏交互。

-

AI代理构建:设计各种强大的AI代理工具。

2.EvoAgentX

简介

EvoAgentX 是一个用于评估和发展代理工作流的自动化框架,可基于自然语言目标自动生成和执行多智能体工作流,还集成了多种进化算法以优化性能。

核心功能

- 自动工作流生成:根据自然语言目标,借助 WorkFlowGenerator 生成工作流,通过 AgentManager 实例化代理并执行。

- 可视化与存储:可对工作流进行可视化展示,支持工作流的保存和加载。

- 进化算法集成:集成 TextGrad、MIPRO 和 AFlow 等进化算法,优化代理系统性能。

技术原理

利用预训练语言模型(如 OpenAI 的 gpt-4o-mini),通过 WorkFlowGenerator 解析自然语言目标生成工作流图,AgentManager 根据工作流图实例化代理,WorkFlow 执行工作流。同时,集成多种进化算法对代理系统进行优化。

应用场景

-

智能求职推荐:根据简历进行智能职位推荐。

-

股票可视化分析:对 A 股股票进行可视化分析。

-

代码生成:如生成俄罗斯方块游戏的 HTML 代码。

-

EvoAgentX/EvoAgentX: 🚀 EvoAgentX: Building a Self-Evolving Ecosystem of AI Agents

2.HuggingGPT

简介

论文主要提出了名为HuggingGPT的系统以解决AI任务,它以语言为接口连接大语言模型(LLMs)与AI模型,让LLMs作为控制器管理AI模型,利用机器学习社区(如Hugging Face)的模型自动解决用户不同请求,在处理复杂AI任务上展现出巨大潜力,为实现通用人工智能开辟新途径。

核心功能

- 任务规划:用ChatGPT分析用户请求,将其拆解为可解决的任务。

- 模型选择:基于模型描述,从Hugging Face选择专家模型解决规划好的任务。

- 任务执行:调用并执行所选模型,将结果返回给ChatGPT。

- 响应生成:整合模型推理结果,以友好人类语言生成响应。

技术原理

- 语言接口:以语言作为LLMs与AI模型协作的通用接口,通过模型描述将其融入提示,使LLMs能管理AI模型。

- 动态上下文任务 - 模型分配:将任务 - 模型分配视为单项选择问题,根据任务类型筛选模型,按下载量排序选前K个作为候选。

- 资源依赖处理:用“”符号维护资源依赖,动态指定任务依赖资源。

应用场景

-

单任务:如识别图像中物体数量、展示搞笑猫图等。

-

顺序任务:像替换图像中物体、基于特定图像生成新图像等。

-

图任务:例如判断图像语义相似性等。

-

[2303.17580] HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in Hugging Face

2.MetaGPT

简介

MetaGPT是一个多智能体框架,可让GPT以软件公司形式协作处理复杂任务。它以一行需求为输入,输出用户故事、竞品分析等内容,内部涵盖产品经理等多种角色,提供软件公司全流程及SOP,核心哲学是 Code = SOP(Team) ,用户还能在自身场景中搭建应用。

核心功能

- 接收一行需求,输出软件相关的多种成果,如用户故事、数据结构、API等。

- 为用户提供软件公司的全流程服务。

- 支持用户在不同场景使用多智能体框架搭建应用。

技术原理

MetaGPT以 Code = SOP(Team) 为核心哲学,将标准操作流程(SOP)具象化并应用于由大语言模型(LLM)构成的团队。通过为不同的LLM分配产品经理、架构师等角色,形成协作实体,以完成复杂任务。

应用场景

-

软件开发:根据需求生成软件项目,如创建2048游戏。

-

数据分析:对数据集进行分析并绘制图表,如对sklearn Iris数据集进行数据分析。

-

特定领域应用:搭建数据解释器、辩论、调研、收据助手等应用。

2.OpenAI Swarm

简介

OpenAI Swarm 是由 OpenAI 解决方案团队管理的一个教育性框架,旨在探索符合人体工学且轻量级的多智能体编排。它提供了一个用于协调多个智能体的实验性平台,是后续生产级工具(如 OpenAI Agents SDK)的前身。

核心功能

- 多智能体协调: 提供机制来协调和管理多个 AI 智能体之间的交互。

- 轻量级编排: 设计理念侧重于简洁和高效地处理智能体任务流。

- 消息传递接口: 其

run()函数类似于 OpenAI 的 Chat Completions API,接收消息、返回消息,且在调用之间不保存状态,实现无状态的智能体交互。 - 后端开发支持: 主要面向需要编程专业知识的后端开发,用于构建多智能体系统。

技术原理

Swarm 的核心技术原理在于其对多智能体系统(Multi-Agent Systems, MAS)的分布式协调与无状态交互模型的实践。它通过一个集中的客户端实例化(Swarm())来抽象化底层复杂性,使开发者能够以简洁的方式调用智能体群组。其 client.run() 方法采用请求-响应模式,不维护会话状态,这与现代无服务器函数或 RESTful API 的设计原则相符,确保了系统的可伸缩性和弹性。该框架探索了智能体间通信协议和任务分解/协作机制,以实现高效的任务分发和结果聚合。

应用场景

- 多智能体系统研究与开发: 作为教育和实验框架,Swarm 适用于研究和原型开发多智能体协作行为。

- 后端服务集成: 可用于探索将多个 AI 智能体能力集成到复杂后端服务中的方法。

- 智能体编排学习: 为开发者和研究人员提供一个理解和实践轻量级智能体编排模式的工具。

- 概念验证(PoC): 用于快速验证多智能体协作解决方案的可行性。

注意: Swarm 是一个实验性项目,已被更成熟的 OpenAI Agents SDK 取代,后者是推荐用于生产环境的多智能体开发工具。

2.Qwen-Agent

简介

Qwen-Agent是一个开发框架,开发者可基于它开发Agent应用,利用通义千问模型(Qwen)的指令遵循、工具使用、规划、记忆能力。项目提供了浏览器助手、代码解释器、自定义助手等示例应用,还支持便捷的GUI接口。

核心功能

- 开发支持:提供大模型(LLM)、工具(Tool)等原子组件和智能体(Agent)等高级抽象组件,方便开发者开发自定义Agent。

- 函数调用:支持函数调用(工具调用),默认工具调用模版原生支持并行工具调用。

- 超长文档问答:有快速的RAG解决方案和准确度较高的智能体,用于超长文档问答。

- GUI接口:支持为Agent快速部署Gradio Demo。

技术原理

- 框架中的LLM继承自

BaseChatModel类,具备Function Calling功能;工具继承自BaseTool类。智能体继承自Agent类,可通过调用LLM和工具完成任务。 - 支持接入阿里云DashScope服务提供的Qwen模型服务,也支持通过OpenAI API方式接入开源的Qwen模型服务。

应用场景

-

浏览器助手:如基于Qwen-Agent构建的BrowserQwen浏览器助手。

-

代码解释器:执行代码相关操作。

-

超长文档问答:在超长文档中进行问答。

2.SmolAgent-huggingface

简介

SmolAgents 是 Hugging Face 开发的一个极简主义 AI 代理库,旨在简化基于大型语言模型(LLMs)的强大 AI 代理的创建和执行。其核心逻辑代码量极小(约 1000 行),强调简洁性、高效性和易用性,使得开发者能够以少量代码构建动态且适应性强的智能代理系统。

核心功能

SmolAgents 的核心功能包括:

- 极简化的代理创建:允许开发者通过极少的代码(例如,不到 30 行)快速定义和运行 AI 代理。

- 代码代理能力:使 AI 代理能够“思考代码”,即具备编写、执行和调试代码的能力,从而与真实世界任务无缝交互。

- 与 LLMs 集成:提供与各种大型语言模型(如 Llama-3.1-8B-Instruct)紧密集成,作为代理的智能核心。

- 工具集成:支持集成外部工具(如 WebSearchTool),扩展代理的能力范围。

- 流式输出:支持代理的流式输出,提高用户体验。

技术原理

SmolAgents 的技术原理基于以下几点:

- 极简抽象层:通过在原始代码之上保持最小化的抽象,实现高度简洁的代码库(

agents.py仅约 1000 行),降低开发复杂性。 - Code-First Agent Design:代理被设计为“思考代码”,这意味着 LLM 的输出直接转化为可执行的代码,从而实现对外部环境的精确控制和交互。

- 模块化工具链:通过

CodeAgent和可插拔的tools(如WebSearchTool)机制,将特定功能封装为代理可调用的模块,实现了功能的扩展性和灵活性。 - 推理客户端模型(InferenceClientModel):提供统一的接口来调用和管理不同的 LLM 推理服务,使得底层模型替换变得透明。

- Python 生态集成:作为 Python 库,能够轻松与 Python 强大的数据处理、网络请求和系统操作能力结合,便于代理执行复杂任务。

应用场景

SmolAgents 可应用于以下场景:

- 自动化任务:开发能够自动执行复杂编程任务、数据分析或系统操作的 AI 代理。

- 智能助手构建:创建能够理解用户意图并执行相应操作的智能编程助手或开发工具。

- 研究与原型开发:为 AI 代理的研究和快速原型验证提供一个简洁高效的平台。

- 教育与学习:作为理解 AI 代理工作原理和 LLM 应用开发的入门工具。

- 领域特定自动化:构建在特定领域(如网页抓取、文本处理、API 调用)中执行自动化任务的代理。

2.XAgent

简介

XAgent是一个开源的、由大语言模型驱动的自主智能体,用于自动解决各种任务。它处于早期阶段,具有自主性、安全性、可扩展性等特点,由调度器、规划器和行动者三部分组成,搭配ToolServer提供工具支持。

核心功能

- 自动解决任务:无需人类参与自动处理各类任务。

- 安全运行:行为限制在docker容器内。

- 可扩展:能添加新工具和智能体。

- 提供交互界面:有GUI和命令行两种交互方式。

- 与人类合作:遵循人类指导,遇挑战时寻求帮助。

技术原理

XAgent由调度器动态实例化和分派任务,规划器将任务分解为子任务并生成计划,行动者利用工具执行任务。ToolServer作为提供工具的服务器,以docker容器形式提供安全运行环境,内置文件编辑器、Python笔记本等工具。

应用场景

-

数据分析:分解任务,完成数据理解、代码编写和报告生成。

-

推荐服务:与人类合作,根据反馈提供个性化推荐。

-

模型训练:下载数据集,训练模型以分析和预测。

-

OpenBMB/XAgent: An Autonomous LLM Agent for Complex Task Solving

2.agentUniverse蚂蚁

简介

agentUniverse 是基于大语言模型的多智能体框架,源于蚂蚁集团金融业务实践。它有丰富的多智能体协作模式组件,支持集成多种 LLM 模型,可助力开发者和企业构建领域专家级智能体。

核心功能

- 灵活构建智能体:提供构建智能体的必要组件,支持定制。

- 多智能体协作:有 PEER、DOE 等协作模式组件,可自定义编排。

- 集成领域经验:支持领域提示、知识构建与管理,注入领域 SOP。

技术原理

agentUniverse 核心是多智能体协作模式组件,作为协作模式工厂,让智能体分工协作。通过简单配置实现 LLM 模型集成,利用工具、知识库、RAG 等技术增强智能体能力。

应用场景

-

金融领域:金融报告生成、金融事件分析。

-

分析研究:事件解读、行业分析。

-

软件开发:Python 代码生成与执行。

-

专业咨询:法律建议、投资研究辅助。

2.agno

简介

Agno是一个轻量级、高性能的开源库和全栈框架,专注于构建AI智能体和多智能体系统。它旨在使智能体具备记忆、知识和推理能力,并能与外部系统集成,提供模型无关、高速且面向未来的智能体构建解决方案。

核心功能

- 高性能智能体构建:支持构建具备记忆、知识和工具使用能力的高性能智能体。

- 多智能体协作:提供先进的多智能体架构(Agent Teams),支持智能体间的推理、记忆和共享上下文。

- 全栈智能体系统:能够构建、部署和监控包含数据库、向量存储和API的全栈智能体系统。

- 模型无关性:可与任何提供商的任何大型语言模型(LLM)配合使用,将LLM转化为智能体。

- 知识库管理:支持知识库(如CSV、URL)的元数据过滤,实现精准的信息检索。

- 开发与监控工具:提供智能体游乐场(Agent Playground)、智能体注册表(Agent Registry)、智能体优化器、安全和防护机制。

技术原理

- 智能体架构:采用模块化设计,通过分层结构赋予智能体记忆模块、知识集成模块和推理引擎,实现高级认知功能。

- 多智能体协作机制:基于共享上下文和协调协议,允许多个智能体组成“智能体团队”,进行并行处理和协同决策,提升复杂任务处理能力。

- 知识检索与增强生成(RAG):通过内置的检索增强生成系统,智能体能够访问外部知识库,并利用元数据过滤精确获取信息,提高生成内容的准确性和深度。

- 插件化工具集成:设计了灵活的工具接口,允许智能体集成和调用外部API、数据库或其他系统,扩展其执行复杂操作的能力。

- 异步与并发处理:框架底层可能采用异步编程和并发机制,以确保智能体在高负载和多任务环境下的高性能和低延迟。

- 模型抽象层:通过抽象层将智能体逻辑与底层LLM模型解耦,实现模型无关性,便于切换和升级LLM,保持技术栈的灵活性。

应用场景

- 智能客服与虚拟助手:构建能够理解复杂查询、具备长期记忆和知识检索能力的智能客服系统。

- 自动化工作流:开发能够集成多种外部工具,自动化执行复杂业务流程的智能体。

- 数据分析与洞察:实现Agentic RAG系统,结合知识库搜索和LLM,从大量数据中提取深度洞察。

- 复杂决策支持系统:利用多智能体系统进行信息收集、分析和协同推理,为人类决策者提供支持。

- AI研究与原型开发:为工程师和研究人员提供一个快速构建、测试和优化AI智能体的平台。

- 企业级智能应用:构建需要高性能、可监控且可部署的企业级智能体应用,如内容生成、代码辅助等。

2.crewAI

简介

CrewAI 是一个全新构建的轻量级、快速的 Python 框架,独立于 LangChain 或其他代理框架。它为开发者提供高级简单性和精确的低级控制,可创建适用于任何场景的自主 AI 代理,已获超 10 万开发者认证,正成为企业级 AI 自动化标准。

核心功能

- 创建 AI 团队:能创建具有特定角色、工具和目标的 AI 团队,实现自主协作智能。

- 任务编排:支持单 LLM 调用进行精确任务编排,具备事件驱动控制。

- 快速构建:通过框架或 UI 工作室,利用无代码工具和模板构建多代理自动化。

- 可靠部署:将构建的团队部署到生产环境,支持不同部署类型并自动生成 UI。

- 监控追踪:监控 AI 代理在简单和复杂任务上的性能和进度。

- 持续迭代:使用测试和训练工具不断提高效率和结果质量。

技术原理

文档未详细提及技术原理相关内容。推测其基于 Python 语言开发,利用大语言模型(LLMs)实现智能决策和任务执行,通过定义角色、工具和目标来组织 AI 团队协作。

应用场景

- 战略规划:使用 LLMs 预测趋势并制定战略业务计划。

- 金融领域:实现自动化财务报告、合规和财务分析。

- 医疗保健:丰富患者数据以改善诊断和个性化护理计划,自动化行政任务。

- 营销领域:进行预测性营销活动、数据驱动的营销和品牌定位。

- 供应链管理:优化库存和物流,提高供应链效率。

- 人力资源:自动化重复性任务,如招聘、入职和员工管理。

- 媒体与娱乐:增强内容创作和分发。

- crewAIInc/crewAI: Framework for orchestrating role-playing, autonomous AI agents. By fostering collaborative intelligence, CrewAI empowers agents to work together seamlessly, tackling complex tasks.

- crewAI

- crewAI - Platform for Multi AI Agents Systems

2.letta

简介

Letta(前身为 MemGPT)是一个开源框架,用于构建具有高级推理能力和透明长期记忆的有状态代理。它是白盒且模型无关的,支持连接多种 LLM API 后端。用户可通过 REST API、Python/Typescript SDK 及 Agent Development Environment(ADE)与代理交互。

核心功能

- 代理构建:利用任意模型构建具备高级记忆和无限上下文的有状态代理,内置持久化和内存管理功能,支持自定义工具和 MCP。

- 可视化调试:借助 ADE 可视化代理的内存、推理步骤和工具调用,实时观察、测试和编辑代理状态。

- 上下文管理:明确约束代理行为以保障可靠性,实现代理的完全自主或完全受控。

- 版本管理:使用代理模板对代理设计进行版本控制,可对现有代理进行升级或回滚更改。

- API 集成:代理以 REST API 端点形式暴露,便于集成到应用程序中。

技术原理

Letta 运用由加州大学伯克利分校的 AI 博士设计的技术来管理上下文和内存,采用模型无关的表示方式自动持久化所有状态,能在不同 LLM 提供商之间迁移代理而不丢失记忆。同时,它支持将自定义工具在云沙箱中执行,可连接 MCP 服务器以附加预构建工具。

应用场景

-

客户支持:构建客户支持聊天机器人,通过长期记忆为客户提供更连贯的服务。

-

智能助手:打造具有高级推理能力和长期记忆的智能助手,满足用户多样化需求。

-

大规模代理部署:从原型扩展到数百万个代理,确保数据、状态和代理记忆不受供应商锁定。

2.mastra

简介

Mastra 是一个基于 TypeScript 构建的、意见鲜明的 AI 代理框架,旨在帮助开发者快速构建和部署人工智能应用及功能。它提供了一套全面的解决方案,使得AI代理的开发、部署、可视化、任务管理和可观察性变得更加高效和便捷。

核心功能

- AI 应用与功能快速构建: 提供一套工具和规范,加速AI应用的开发流程。

- AI 代理管理: 支持构建和管理各种AI代理,包括部署、工作流可视化、长任务处理等。

- 可观察性: 内置可观察性工具,便于监控和调试AI代理的运行状态。

- RAG 支持: 集成了检索增强生成(RAG)功能,允许代理利用知识库进行查询和回答。

- 多LLM兼容性: 支持多种大型语言模型(LLM),如 GPT-4, Claude, Gemini, Llama 等,提供灵活的模型选择。

- TypeScript 原生: 提供 TypeScript 语言支持,利用其类型安全和开发效率优势。

技术原理

Mastra 的核心技术原理是基于 TypeScript 构建一套结构化且可扩展的 AI 代理框架。它通过抽象和封装底层复杂的AI交互逻辑,提供简洁的API接口,实现对各种LLM的统一调用和管理。框架内部可能采用模块化设计,将代理的创建、执行、状态管理和外部工具集成等功能进行解耦。对于RAG功能,其可能通过集成向量数据库和语义搜索技术,使AI代理能够访问并利用外部知识库信息。

应用场景

- AI 代理开发: 适用于需要构建复杂AI代理,如智能客服、自动化工作流代理、数据分析代理等。

- Web 搜索AI代理: 可用于开发能够进行网络搜索并整合信息的智能代理。

- AI 工作流自动化: 帮助将AI能力集成到现有业务流程中,实现自动化和智能化。

- 大语言模型应用开发: 为基于不同LLM构建的各类AI应用程序提供统一的开发和部署平台。

- 企业级AI解决方案: 适用于需要可扩展、可维护且具有良好可观察性的企业级AI项目。

2.pr-agent

简介

PR - Agent是一个用于自动分析、反馈和提供建议的AI工具,可帮助高效审查和处理拉取请求(PR)。支持GitHub、GitLab、BitBucket等多个平台,有多种使用方式。Qodo Merge是其托管版本,具有更多高级功能、更好的隐私保护和优先支持。

核心功能

- PR审查与改进:提供AI反馈和建议,对PR进行审查和改进。

- 多平台支持:支持GitHub、GitLab、BitBucket、Azure DevOps、Gitea等平台。

- 多方式使用:支持CLI、GitHub Action、GitHub App、Docker等使用方式。

- 高级功能:Qodo Merge具有静态代码分析、自定义配置、数据隐私保护等高级功能。

技术原理

- PR压缩策略:将代码差异转换为可管理的大语言模型(LLM)提示,有效处理短和长PR。

- JSON提示策略:实现模块化、可定制的工具,可通过配置文件控制工具类别。

- 多模型支持:支持GPT、Claude、Deepseek等多种模型。

- RAG上下文丰富:丰富上下文信息,提升处理效果。

应用场景

-

代码审查:自动审查PR,提供反馈和改进建议。

-

项目管理:在多个代码托管平台上辅助项目管理。

-

本地开发:通过CLI在本地仓库运行,或在本地IDE使用Qodo Merge获取自动反馈。

2.pydantic-ai

简介

PydanticAI 是一个 Python 代理框架,由 Pydantic 团队开发,旨在为生成式 AI 应用开发带来类似 FastAPI 的开发体验。它支持多种模型,能与 Pydantic Logfire 集成,具备类型安全、结构化响应等特性。

核心功能

- 多模型支持:支持 OpenAI、Anthropic、Gemini 等多种模型。

- 集成调试:与 Pydantic Logfire 集成,用于实时调试、性能监控和行为跟踪。

- 类型安全:增强类型检查功能。

- 结构化响应:利用 Pydantic 验证和结构化模型输出。

- 依赖注入:提供依赖注入系统,便于测试和迭代开发。

- 流式响应:可连续流式输出 LLM 结果并即时验证。

- 图支持:通过 Pydantic Graph 用类型提示定义图。

技术原理

PydanticAI 基于 Python 构建,利用 Pydantic 的数据验证和结构化能力,结合 Python 熟悉的控制流和代理组合方式。通过类型提示确保代码的类型安全,使用依赖注入系统提供数据和服务,利用 Pydantic Graph 以类型提示定义图来处理复杂应用逻辑。

应用场景

-

AI 驱动项目开发:借助 Python 最佳实践构建 AI 项目。

-

复杂应用开发:利用图支持处理复杂应用中的逻辑。

-

LLM 应用调试与监控:通过 Pydantic Logfire 集成进行实时调试和性能监控。

-

pydantic/pydantic-ai: Agent Framework / shim to use Pydantic with LLMs

2.微软Autogen+Magentic-One+RD-Agent

简介

AutoGen是微软开发的用于创建多智能体AI应用程序的框架,支持智能体自主行动或与人类协作。其生态系统提供创建AI智能体所需的一切,具有分层和可扩展的设计,有Core API、AgentChat API和Extensions API等不同层次的API,还支持.NET和Python跨语言。此外,还有AutoGen Studio和AutoGen Bench等开发工具,目前也公布了不同版本的开发路线图。

核心功能

- 多智能体对话:提供统一的多智能体对话框架,实现智能体间自动聊天以完成任务。

- 智能体定制:可定制智能体,集成大语言模型、人类、工具或其组合。

- 代码执行:支持执行代码以调用工具解决任务。

- 无代码GUI:AutoGen Studio支持无代码原型设计和运行多智能体工作流。

- 基准测试:AutoGen Bench可评估智能体性能。

技术原理

- 分层架构:采用分层和可扩展设计,各层职责明确,上层基于下层构建,支持不同抽象级别的使用。

- 核心API:实现消息传递、事件驱动智能体以及本地和分布式运行时,支持跨语言。

- AgentChat API:基于核心API构建,提供更简单的API用于快速原型设计。

- Extensions API:支持第一方和第三方扩展,不断扩展框架功能。

应用场景

-

信息检索与总结:如通过智能体团队查找信息并撰写总结。

-

多智能体工作流原型设计:使用AutoGen Studio无需编写代码即可进行多智能体工作流的原型设计和运行。

-

复杂任务处理:构建如Magentic - One这样的多智能体团队,处理需要网页浏览、代码执行和文件处理的任务。

AutoGen Studio可视化低代码

简介

Autogen Studio是基于Autogen框架构建的低代码界面,用于快速搭建AI智能体原型,为其添加技能、组合成工作流并与之交互以完成任务。它并非生产就绪的应用,鼓励开发者使用Autogen框架构建自己的应用。其代码托管在GitHub的microsoft/autogen仓库。

核心功能

- 快速搭建AI智能体原型,为智能体添加技能并组合成工作流。

- 支持与智能体工作流进行交互并指定任务。

- 在界面中查看智能体消息和输出文件。

技术原理

Autogen Studio基于Autogen框架,其数据库层使用SQLModel(Pydantic + SQLAlchemy),提供实体链接功能,支持SQLAlchemy所支持的多种数据库后端方言,如SQLite、PostgreSQL等。前端使用Gatsby和Tailwind CSS构建。

应用场景

主要用于快速进行多智能体工作流的原型设计,演示使用Autogen构建的最终用户界面示例,帮助开发者验证和展示AI智能体工作流的可行性。

- autogen/samples/apps/autogen-studio at main · microsoft/autogen

- AutoGen Studio - Getting Started | AutoGen

RD-Agent

简介

RD - Agent由微软开发,致力于自动化工业研发流程中关键且有价值的部分,尤其关注数据驱动场景,以优化模型和数据开发。它在MLE - bench基准测试中表现领先,还有用于量化金融的RD - Agent(Q)版本,在真实股市实验中效果良好。

核心功能

- 自动化研发:自动完成工业研发流程中的关键环节,如模型和数据开发。

- 基准测试领先:在MLE - bench中作为顶级机器学习工程代理,展现出较强的性能。

- 量化金融应用:RD - Agent(Q)可实现定量策略的全栈研究和开发,实现因子 - 模型联合优化。

- 多场景支持:适用于金融、医疗、通用等多个数据驱动的工业场景。

技术原理

RD - Agent的框架包含三个主要研究领域:一是通过基准测试评估研发能力;二是探索新想法或完善现有想法;三是实现和执行想法。它建立了一个不断提出假设、验证假设并从实际应用中获取反馈的方法框架,支持与现实世界验证相连接。

应用场景

-

金融领域:自动进行定量交易、迭代因子模型联合进化、从财务报告中提取因子等。

-

医疗领域:在模型实现方面迭代提出想法并进化。

-

通用领域:自动读取论文并实现模型结构、自动进行Kaggle模型调优和特征工程等。

3.Agenta

简介

Agenta是一个全面的LLMOps平台,集prompt管理、评估、人类反馈和部署等功能于一体,旨在简化大型语言模型(LLM)的操作和维护工作,提高效率和效果。该项目为开源项目,社区活跃且持续更新,采用MIT许可证。

核心功能

- 提供全面的prompt管理功能。

- 支持大型语言模型的评估和测试。

- 集成人类反馈机制,优化模型性能。

- 一站式部署,简化LLM的应用流程。

技术原理

项目使用Python和TypeScript作为主要开发语言,涉及prompt工具、评估、反馈和部署等多方面技术实现,支持prompt工具、rag、LLM等多个相关技术和工具的集成。

应用场景

适用于需要操作和维护大型语言模型的场景,如模型开发、测试、优化及部署等,可帮助相关人员提高工作效率和效果。

- Agenta-AI/agenta: The all-in-one LLM developer platform: prompt management, evaluation, human feedback, and deployment all in one place.

- 项目详情 | SOTA!模型社区

3.SuperAGI

简介

SuperAGI是一个面向开发者的开源自主AI代理框架。它旨在帮助开发者快速、可靠地构建、管理和运行有用的自主AI代理,提供了一个全面的平台,支持代理的开发、部署和操作,并提供Web界面访问。

核心功能

- 自主AI代理构建与管理: 提供一个框架,使开发者能够轻松创建、部署和管理自主AI代理。

- 多工具集集成: 支持集成多种工具集,如Google Search, GitHub, Jira等,通过配置API密钥/ID/令牌来扩展代理能力。

- 大型语言模型(LLM)支持: 允许无缝配置和集成本地LLM,以及使用OpenAI API密钥。

- Web界面与API访问: 提供Web版本供用户通过浏览器访问,无需本地安装;同时提供公共API,支持云端或本地基础URL访问。

- 持久化记忆与数据管理: 集成Weaviate DB进行知识管理和LTM (长期记忆) 用于“思考工具”。

- 多GPU支持: 框架支持多GPU配置,以优化性能。

技术原理

SuperAGI的核心是一个“dev-first”的自主AI代理框架,这意味着它提供了开发者友好的接口和工具来构建和操作AI代理。其技术原理包括:

- 模块化架构: 框架设计支持集成不同的组件,如各种工具集(Toolkits)和LLM。

- API驱动: 代理可以通过配置外部工具的API密钥来与外部服务进行交互。

- LLM集成: 能够灵活地与各种大语言模型对接,包括云端模型(如OpenAI)和本地部署的模型。

- 向量数据库应用: 利用Weaviate等向量数据库作为长期记忆(LTM)和知识管理的基础,使代理能够存储、检索和利用历史信息进行决策和推理。

- 分布式计算支持: 通过多GPU支持,可能利用并行计算来加速模型推理和训练过程。

应用场景

- 自动化任务执行: 开发能够自主执行复杂、多步骤任务的AI代理,例如项目管理、代码审查、数据分析等。

- 智能客户服务: 构建能够理解和响应用户查询,并与外部系统(如CRM、工单系统)集成的智能客服代理。

- 数据洞察与报告: 利用工具集从互联网或内部数据源收集信息,生成报告或提供决策支持。

- 软件开发辅助: 创建能够辅助开发工作的AI代理,例如自动生成代码、进行测试、管理版本控制等。

- 个性化推荐系统: 利用代理的自主学习和记忆能力,为用户提供高度个性化的内容或产品推荐。

3.atomic-agents

简介

Atomic Agents是一个围绕原子性概念设计的轻量级、模块化框架,用于构建智能AI管道和应用程序。它基于Instructor构建,利用Pydantic进行数据和模式验证与序列化,所有逻辑和控制流用Python编写,兼顾开发者体验和可维护性。

核心功能

- 模块化构建:通过组合小型、可重用组件构建AI应用。

- 可预测性:定义清晰的输入输出模式,确保行为一致。

- 可扩展性:轻松替换或集成新组件,不影响整个系统。

- 精细控制:可单独微调系统各部分,从系统提示到工具集成。

- 动态上下文注入:使用上下文提供程序在运行时注入额外信息。

- 组件链:通过对齐输入输出模式,方便地链接代理和工具。

技术原理

基于Instructor和Pydantic,利用Python编写逻辑和控制流。代理由系统提示、输入输出模式、内存和上下文提供程序等组件构成,通过定义清晰的模式和流程,实现可预测、可扩展的AI应用开发。

应用场景

-

聊天机器人:如基本聊天机器人、自定义聊天机器人等。

-

信息提取与分析:如从图像、视频中提取结构化信息。

-

研究任务:执行深度研究任务。

-

搜索与问答:执行网页搜索并回答问题。

-

内容总结:总结YouTube视频内容。

3.muAgent-蚂蚁

简介

CodeFuse-muAgent 是由知识图谱引擎驱动的创新 Agent 框架,基于 LLM+EKG 驱动,协同 MultiAgent、FunctionCall、CodeInterpreter 等技术。它兼容市面现有 Agent 框架,可实现复杂推理、在线协同、人工交互、知识即用四大核心差异技术功能,已在蚂蚁集团多个复杂 DevOps 场景落地验证。自 2024 年 4 月 1 日开源以来不断更新迭代,2025 年 1 月 13 日发布 muAgent v2.2 并提供 muAgent-sdk v0.1.0 支持 ekg-sdk 和 ekg 并行执行。

核心功能

- 多技术协同:结合 LLM、EKG、MultiAgent、FunctionCall、CodeInterpreter 等技术。

- 复杂 SOP 流程实现:通过画布式拖拽和轻文字编写,让大模型在人的经验指导下执行复杂 SOP 流程。

- 四大核心功能:复杂推理、在线协同、人工交互、知识即用。

- 多场景支持:满足各类 SOP 场景,适用于多人文本游戏等。

技术原理

- 图谱构建:通过虚拟团队构建、场景意图划分,支持文本智能解析、一键导入海量存量文档,体现在线协同优势。

- 图谱资产:通过统一图谱设计,纳入工具、人物/智能体,提升工具选择和参数填充准确性,让人可参与流程推进。

- 图谱推理:大模型在人的经验/设计指导下推理,可探索未知局面并沉淀经验。

- 调试运行:图谱编辑后可视调试,沉淀成功路径配置,减少模型开销,提供全链路可视化监控。

- 记忆管理:统一消息池设计,支持消息分类投递、订阅,处理超长上下文。

- 操作空间:遵循 Swagger 协议,提供工具注册、权限管理,保障安全可信代码执行环境和精准代码生成。

应用场景

-

DevOps 场景:在蚂蚁集团内多个复杂 DevOps 场景落地验证。

-

多人文本游戏:如谁是卧底游戏。

-

各类 SOP 场景:满足各类 SOP 流程的自动化需求。

-

CodeFuse-muAgent/README_zh.md at main · codefuse-ai/CodeFuse-muAgent

-

codefuse-ai/CodeFuse-muAgent: A Multi-Agent FrameWork For Faster Build Agents

3.superagent[停更]

简介

Superagent 是开源的 AI 助手框架与 API,由 Y Combinator 支持。它可让开发者将强大的 AI 助手添加到应用程序中,借助大语言模型(LLM)、检索增强生成(RAG)和生成式 AI 为用户提供帮助。

核心功能

- 支持构建多种 AI 应用,如问答系统、聊天机器人、AI 助手等。

- 具备记忆、流式传输功能。

- 提供 Python 和 Typescript SDK 以及 REST API。

- 支持 API 连接、矢量化,可对接第三方矢量存储和多种 LLM。

- 支持 API 并发。

技术原理

基于大语言模型(LLM)进行语言理解和生成,运用检索增强生成(RAG)技术结合外部知识源,通过矢量化处理数据并存储于第三方矢量存储,利用 REST API 实现与应用的交互。

应用场景

-

文档问答:基于文档进行问答。

-

聊天机器人开发。

-

开发协同编辑助手和 AI 助手。

-

内容生成。

-

数据聚合。

-

工作流自动化。

3.AGiXT

简介

AGiXT是一个动态的人工智能自动化平台,旨在跨多个AI提供商高效管理指令和执行任务。它结合了自适应内存、智能功能和多功能插件系统,提升AI性能与响应能力,推动人工智能通用化(AGI)发展。

核心功能

- 上下文与令牌管理:自适应处理长短期记忆,优化AI性能。

- 智能指令:借助网络搜索和规划策略,使AI有效理解、规划和执行任务。

- 交互式聊天与智能聊天:用户友好的聊天界面,智能聊天结合网络研究提供准确回复。

- 任务执行与智能任务管理:高效管理和执行复杂任务,分解为子任务并避免冗余。

- 链管理:处理一系列链接命令,自动化复杂工作流程。

- 网页浏览与命令执行:具备网页浏览和命令执行能力,增强AI交互性。

- 多提供商兼容性:与OpenAI、ezLocalai、Hugging Face等主流AI提供商集成。

- 多功能插件系统与代码评估:支持多种AI模型扩展命令,提供代码评估辅助。

- Docker部署:简化设置和维护。

- 音频与文本转换:集成Hugging Face实现音频与文本转换。

- 平台互操作性与AI代理管理:可创建、重命名、删除和更新AI代理设置,与多平台交互。

- 自定义提示与命令控制:可控制代理能力,创建、编辑和删除自定义提示。

- RESTful API:便于与外部应用和服务集成。

技术原理

AGiXT通过初始化代理、记忆,对用户输入的文本、语音、图像、文件等进行多模态处理。利用向量数据库和嵌入提供程序管理记忆,在执行命令、链和推理时注入用户设置、代理扩展设置和相关记忆。同时借助网络搜索获取信息,结合主流AI提供商的能力完成任务,并对整个过程进行日志记录。

应用场景

-

编程辅助:提供代码评估和编程任务协助。

-

信息查询:结合网络搜索,为用户提供准确的信息回复。

-

复杂任务管理:将复杂任务分解为子任务,高效执行和管理。

-

智能对话:通过交互式聊天界面,实现与用户的动态对话。

3.minion-agent

简介

Minion Agent 是一个简单的智能体框架,具备浏览器使用、MCP(Model Context Protocol)、自动检测、规划、深度研究等功能,可通过 pip 安装,也能从源码安装。

核心功能

- 多功能支持:支持浏览器使用、MCP 工具、自动规划、深度研究等。

- 可配置性:通过

AgentConfig类可对模型、名称、工具等进行配置。 - 多 MCP 工具使用:支持标准 MCP 工具和基于 SSE 的 MCP 工具,还可同时使用多个。

技术原理

- 借助配置类

AgentConfig对智能体的各项参数进行设置,包括模型 ID、使用工具、规划间隔等。 - 利用 MCP 协议实现与外部工具的交互,通过不同的 MCP 工具配置方式适应不同场景。

- 依据

planning_interval参数实现自动规划,按计划执行任务并定期重新评估和制定新计划。

应用场景

-

价格比较:可用于比较不同平台的商品价格。

-

深度研究:对特定主题进行深入研究。

-

游戏生成:例如生成蛇形游戏等。

3.AgentBench智谱

简介

AgentBench是首个用于跨不同环境评估大语言模型(LLM)作为代理能力的基准测试工具。它涵盖8种不同环境,包括5个新创建领域和3个从已发布数据集重新编译的领域,能更全面评估LLM在各种场景下作为自主代理的能力。此外还推出了用于评估和训练视觉基础代理的VisualAgentBench。

核心功能

- 对多种大语言模型在不同环境下作为代理的能力进行评估。

- 提供Dev和Test两种数据集划分,支持多轮交互测试。

- 为部分模型提供测试结果,展示模型在测试集上的得分。

技术原理

基于不同环境构建评估框架,通过多轮交互让大语言模型在各环境中执行任务,根据其生成结果的情况进行评估。框架结构经过设计,方便使用和扩展,还可通过配置文件调整任务设置。

应用场景

-

研究机构和开发者用于评估不同大语言模型作为自主代理的性能,助力模型的研发和改进。

-

帮助选择适合特定场景的大语言模型代理,例如操作系统操作、数据库管理、知识图谱应用等场景。

-

THUDM/AgentBench: A Comprehensive Benchmark to Evaluate LLMs as Agents (ICLR'24)

3.ERNIE Bot

简介

内容主要围绕ERNIE相关的开发工具和应用展开。ERNIE SDK包含ERNIE Bot Agent和ERNIE Bot两个项目,前者是大模型智能体开发框架,有编排能力、丰富组件库且开发门槛低;后者为开发者提供调用文心大模型基础功能的接口。此外,还有LLM2Json工具可引导大语言模型输出符合JSON语法的数据,ERNIEBot Researcher能进行在线研究并生成研究报告。

核心功能

- ERNIE SDK:ERNIE Bot Agent实现多工具编排和调度,提供预置组件库,支持零代码和简洁代码开发智能体应用;ERNIE Bot提供调用文心大模型文本创作、对话等功能的接口。

- LLM2Json:自动构建prompts引导大语言模型输出符合JSON语法的返回数据。

- ERNIEBot Researcher:根据研究任务生成研究问题,从知识库选信息,过滤汇总生成研究报告,支持多报告并行生成、质量评估和修订完善。

技术原理

- ERNIE SDK:ERNIE Bot Agent基于文心大模型的Function Calling能力实现编排和调度;ERNIE Bot作为底层依赖调用文心大模型。

- LLM2Json:参考LangChain,通过自动构建prompts引导大语言模型输出。

- ERNIEBot Researcher:结合Plan-and-Solve技术和RAG技术,利用ernie-4.0做决策规划、ernie-3.5-8k撰写报告,通过多Agent协作和并行处理完成任务。

应用场景

-

ERNIE SDK:可用于开发各类AI原生应用,如智能客服、智能写作助手等。

-

LLM2Json:适用于需要大语言模型输出结果与其他程序进行数据交互的场景,如前端开发、GPTs和Agents开发等。

-

ERNIEBot Researcher:适合网页、期刊、企业办公文档等场景的研究报告生成。

3.NVIDIA AgentIQ

简介

NVIDIA AgentIQ 是一个开源工具包,旨在高效连接和优化人工智能代理团队。它提供了一个灵活的库,能够无缝集成不同框架下的企业代理,并连接到各种数据源和工具,从而实现代理、工具和代理工作流的真正可组合性。

核心功能

- 跨框架代理集成: 能够集成使用不同AI框架开发的代理。

- 多源数据连接: 实现代理与多种数据源的连接。

- 工具集成: 支持代理与各种工具的结合使用。

- 代理工作流可组合性: 将代理、工具和代理工作流视为简单的函数调用,实现“构建一次,随处重用”的高度可组合性。

- 团队优化: 专注于优化AI代理团队的协作和性能。

技术原理

AgentIQ 的核心技术原理在于其将AI代理、外部工具和复杂的代理工作流抽象为可调用的函数。这种设计模式使得系统能够以统一且模块化的方式管理和编排这些组件,无论其底层实现框架如何。通过函数调用的方式,AgentIQ 实现了高度的解耦和可重用性,允许开发者将不同功能单元进行灵活组合,形成复杂的智能代理系统。其开源库的特性也意味着它可能利用了现有成熟的AI和软件工程实践,提供标准化的接口和协议来促进不同组件间的通信和数据交换。

应用场景

- 企业级AI代理系统开发: 构建需要集成多种AI代理、数据源和工具的复杂企业级智能系统。

- 跨部门自动化工作流: 部署由不同AI代理协作完成的自动化业务流程,例如数据分析、客户服务、决策支持等。

- 多模态AI应用: 开发需要结合不同类型AI模型(如LLM、视觉模型)和工具的应用。

- 智能体编排与管理: 统一管理和优化大规模AI代理团队的性能和协作效率。

- AI研发与测试: 为AI代理的开发、测试和迭代提供一个灵活且可扩展的平台。

3.PC-Agent-E上交大+SII推出

简介

PC Agent - E是一个高效的代理训练框架,旨在以显著的数据效率激发强大的计算机使用能力。该框架从仅312条人工注释的计算机使用轨迹开始,通过Claude 3.7 Sonnet合成多样化的行动决策,进一步提高数据质量。训练后的PC Agent - E模型在WindowsAgentArena - V2基准测试中取得了显著的相对改进,超越了Claude 3.7 Sonnet,并在OSWorld上展示了对不同操作系统的强大泛化能力。

核心功能

- 轨迹收集:使用PC Tracker工具记录人类计算机使用轨迹,收集屏幕状态观察和人类操作,过滤错误步骤和轨迹。

- 思维补全:基于屏幕状态观察和历史步骤上下文,重建每个行动决策前的潜在人类思维过程。

- 轨迹增强:利用Claude 3.7 Sonnet为轨迹的每个步骤合成多样化的替代行动决策,增强轨迹数据的丰富性和多样性。

- 代理训练:在增强的轨迹上训练PC Agent - E模型,使其具备强大的计算机使用能力。

技术原理

- 轨迹收集:借助PC Tracker记录人类与计算机交互过程中的屏幕状态和操作,采用规则过滤数据,确保数据质量。

- 思维补全:通过迭代方法,为Claude 3.7 Sonnet提供任务描述、历史操作、当前操作和截图等信息,重建人类操作背后的思维过程。

- 轨迹增强:利用Claude 3.7 Sonnet的长程规划能力和先进推理模式,针对人类轨迹的每个步骤生成多个合理的替代行动决策。

- 代理训练:以Qwen2.5 - VL - 72B为基础模型,采用简单的端到端架构,在增强的轨迹数据上进行训练。

应用场景

- 自动化办公:可用于自动完成如文档处理、表格制作、邮件发送等日常办公任务。

- 系统管理:协助进行系统配置、软件安装、文件管理等操作。

- 软件测试:自动执行软件测试任务,提高测试效率和准确性。

- GAIR-NLP/PC-Agent-E: Efficient Agent Training for Computer Use

- gair-nlp.github.io

- henryhe0123/PC-Agent-E · Hugging Face

- 2505.13909

3.Salesforce MAS Agent框架

简介

MAS-ZERO 是 Salesforce AI Research 推出的首个用于自动设计多智能体系统(MAS)的自进化推理时框架。它无需验证集,通过元级设计迭代生成、评估和完善 MAS 配置,能动态组合智能体和分解问题,在数学、研究生级问答和软件工程等基准测试中表现出色,优于手动和现有自动 MAS 基线。

核心功能

- 自动设计:自动设计与底层大语言模型(LLM)能力相匹配的智能体结构。

- 自适应优化:针对每个问题实例自适应优化 MAS 配置,提升解决复杂问题的能力。

- 自验证:从候选答案中选择最可靠和完整的答案。

技术原理

- 元迭代:元智能体通过观察系统级和组件级性能学习组件智能体的潜力,包括元设计(将问题分解为子任务并提出 MAS)和元反馈(评估 MAS 和子任务并生成反馈)两个主要功能。

- 自验证:将验证问题转化为选择问题,元智能体从候选答案中选择最连贯和正确的输出。

应用场景

-

数学领域:解决如 AIME24 等数学基准测试中的复杂问题。

-

研究生级问答:处理 GPQA - diamond 等研究生级别的问答任务。

-

软件工程:应对 SWE - Bench - Lite - Oracle 等代码领域的挑战。

-

SalesforceAIResearch/MAS-Zero: Designing Multi-Agent Systems with Zero Supervision

-

MAS-Zero: Designing Multi-Agent Systems with Zero Supervision

-

MAS-ZERO: Designing Multi-Agent Systems with Zero Supervision

3.TaskWeaver微软

简介

TaskWeaver是由微软开发的一个以代码为优先的代理框架,用于无缝规划和执行数据分析任务。它通过代码片段解释用户请求,以函数形式协调各种插件,实现有状态的数据处理。该框架支持多种大语言模型,具有易使用、易调试、易扩展等特点。

核心功能

- 复杂任务规划:具备任务分解和进度跟踪能力,可解决复杂任务。

- 反思性执行:支持对执行过程进行反思并调整。

- 丰富数据处理:允许使用Python中的丰富数据结构,如DataFrames。

- 自定义算法封装:可将自定义算法封装成插件并编排使用。

- 融入领域知识:便于融入特定领域知识,提高执行可靠性。

- 有状态执行:支持生成代码的有状态执行,确保用户体验一致流畅。

- 代码验证:执行前验证生成的代码,检测并提供修复建议。

- 安全会话管理:支持基本会话管理,隔离不同用户数据。

技术原理

TaskWeaver基于大语言模型,通过代码片段理解用户请求,将其转化为可执行的数据分析任务。它结合任务分解和进度跟踪技术,对复杂任务进行规划。在执行过程中,利用反思机制调整执行策略。同时,借助代码验证技术确保生成代码的可靠性,通过会话管理和沙盒环境保障数据安全和执行安全。

应用场景

-

数据分析:处理和分析高维表格数据等复杂数据结构。

-

工作流自动化:编排自定义算法和插件,实现工作流自动化。

-

科研辅助:作为研究工具,辅助科研人员进行数据分析和实验。

3.babyagi

简介

BabyAGI是一个用于自构建自主代理的实验性框架,由Yohei开发。其核心是新的函数框架(functionz),可存储、管理和执行数据库中的函数,具有基于图的结构来跟踪导入、依赖函数和认证密钥,还配备了用于管理函数、运行更新和查看日志的仪表板。最初版本在2023年引入任务规划作为开发自主代理的方法,当前版本强调以最简单的自构建方式打造通用自主代理。

核心功能

- 函数管理:可注册、加载、存储和执行函数,支持将相关函数组织成包,便于构建和管理。

- 密钥管理:能从代码中或通过仪表板存储和管理关键依赖项(如API密钥)。

- 执行环境管理:自动加载必要的函数包,管理依赖关系,确保执行环境无缝运行。

- 日志记录:记录函数执行的各个方面,包括输入、输出、执行时间、错误等,便于监控和调试。

- 触发机制:允许特定函数根据系统内的特定事件或操作自动执行。

- 自主任务执行:用户提供初始目标和任务,执行代理完成任务,任务创建代理根据结果创建后续任务,优先级代理调整任务列表。

技术原理

- 函数框架:采用functionz框架,以图结构存储函数的导入、依赖和认证信息,实现函数的自动加载和全面日志记录。

- 任务驱动架构:用户设定初始目标和任务,通过执行、任务创建和优先级调整三个代理协同工作,不断生成和执行任务。

- 向量存储:使用Pinecone将任务/结果对存储为嵌入式向量,在任务执行和创建时提取最相关的上下文。

应用场景

-

自动化工作流:如自动处理业务流程中的各种任务,减少人工干预。

-

信息收集与整合:从多个应用(如Airtable CRM、Google Drive)中收集和整合信息。

-

代码生成:根据用户描述生成代码,辅助软件开发。

3.core

简介

Cheshire Cat是一个用于构建自定义AI代理的框架,具有API优先、支持多种交互方式、内置RAG、可通过插件扩展等特点,支持多用户并具备细粒度权限,采用docker化部署。

核心功能

- 为应用添加对话层,支持通过WebSocket聊天和使用可定制的REST API管理代理。

- 内置RAG,支持通过langchain使用任何语言模型。

- 可通过插件扩展功能,具备事件回调、函数调用、对话表单等机制。

- 拥有易于使用的管理面板,支持多用户并可设置细粒度权限。

技术原理

基于API优先设计,利用WebSocket实现聊天交互,REST API进行代理管理。内置RAG使用Qdrant,通过langchain支持多种语言模型。借助事件回调、函数调用等机制实现功能扩展,采用docker化部署确保环境一致性。

应用场景

-

为各类应用添加对话交互功能,如智能客服、智能助手等。

-

适用于需要处理多用户对话且具备权限管理的场景。

-

可用于构建特定领域的AI代理,通过插件扩展满足不同业务需求。

3.gpt-engineer

简介

gpt - engineer是一个代码生成实验平台,允许用户用自然语言指定软件需求,让AI编写并执行代码,还能要求AI进行改进。它支持多种安装方式,默认支持OpenAI、Azure OpenAI、Anthropic等模型,也可通过额外设置使用开源模型。lovable.dev则可让用户通过与AI聊天创建应用和网站。

核心功能

- 代码生成与改进:依据自然语言描述生成代码,对现有代码进行改进。

- 模型支持:支持多种模型,包括OpenAI、Azure OpenAI、Anthropic模型及开源模型。

- 基准测试:提供“bench”二进制文件,用于将自定义代理与公共数据集进行基准测试。

- 自定义AI身份:可通过覆盖“preprompts”文件夹来指定AI代理的“身份”。

- 图像输入:支持为具有视觉能力的模型提供图像输入。

技术原理

gpt - engineer主要基于大语言模型的自然语言处理能力,利用API与模型交互,将用户的自然语言描述转化为代码。通过对预提示(preprompts)的设置来引导模型输出符合特定需求的代码,同时可结合图像等额外信息辅助模型理解。对于不同模型,适配相应的API进行通信。

应用场景

-

软件开发:快速生成软件代码,提高开发效率。

-

代码优化:对已有代码进行功能增强和性能优化。

-

模型研究:用于研究和测试不同的编码代理模型。

-

网站与应用创建:通过lovable.dev平台,非技术人员也能与AI交流创建应用和网站。

-

AntonOsika/gpt-engineer: CLI platform to experiment with codegen. Precursor to: https://lovable.dev

3.gpt-researcher

简介

GPT Researcher 是一个用于网络和本地研究的开源深度研究智能体,能生成详细、客观且带引用的研究报告,具备多种定制选项。它利用“计划者”和“执行者”代理架构,解决了人工研究耗时久、大语言模型信息过时、现有服务资源有限等问题。

核心功能

- 生成详细研究报告,包含研究问题、大纲、资源等。

- 智能图像抓取与过滤,用于报告内容。

- 生成超 2000 字的详细报告,汇总超 20 个来源形成客观结论。

- 支持 JavaScript 网页抓取,维护研究过程中的记忆和上下文。

- 提供轻量级和生产级前端版本,可将报告导出为多种格式。

- 支持 MCP 集成,可连接专业数据源;具备深度研究功能,采用树状探索模式。

- 可基于本地文档(PDF、文本、CSV 等)进行研究。

技术原理

核心是利用“计划者”和“执行者”代理。计划者生成研究问题,执行者收集相关信息,最后由发布者将结果汇总成综合报告。同时利用 gpt - 40 - mini 和 gpt - 4o(128K 上下文)完成研究任务,并对成本进行优化。

应用场景

-

学术研究:帮助学者快速收集资料、生成研究报告。

-

商业调研:为企业提供市场分析、竞品研究等报告。

-

内容创作:为创作者提供丰富素材和研究支持。

-

信息检索:快速从大量网页和本地文档中获取所需信息。

-

gpt-researcher/README-zh_CN.md at master · assafelovic/gpt-researcher

3.ii-agent

简介

II-Agent 是一个开源智能助手,旨在跨多个领域简化和增强工作流程。它围绕领先语言模型提供代理接口,有 CLI 和 WebSocket 服务器,集成多个 LLM 提供商。在 GAIA 基准测试中表现出色,能执行复杂任务,提升生产力。

核心功能

- 多领域支持:涵盖研究、内容生成、数据分析、软件开发、工作流自动化和问题解决等领域。

- 交互方式:提供 CLI 接口和基于 WebSocket 的前端交互。

- 集成多种 LLM:如 Anthropic Claude、Google Gemini 等。

- 多功能执行:包括文件操作、命令执行、网页交互、任务报告等。

技术原理

- 核心架构与交互:通过动态定制上下文的系统提示、交互历史管理、智能上下文管理处理令牌限制,系统调用和选择 LLM 能力。

- 规划与反思:结构化推理、问题分解、透明决策、假设形成与测试。

- 执行能力:文件系统操作、命令行执行、网页交互、任务完成与报告。

- 上下文管理:令牌使用估计与优化、长交互截断、文件存档。

- 实时通信:基于 WebSocket 实现交互式通信。

应用场景

-

研究与内容创作:多步网络搜索、内容生成、数据可视化。

-

软件开发:代码合成、调试、教程编写。

-

工作流优化:脚本生成、浏览器自动化、文件管理。

-

问题解决:分解问题、探索替代路径、提供指导。

3.lagent

简介

Lagent是一个轻量级的开源框架,受PyTorch设计哲学启发,允许用户高效构建基于大语言模型(LLM)的智能体,提供了多种功能和工具以支持智能体开发。

核心功能

- 智能体通信:使用

AgentMessage进行通信,智能体可处理用户消息并生成回复。 - 记忆管理:每次交互的输入输出消息会添加到智能体的记忆中,支持多种方式查看记忆。

- 消息聚合:提供默认聚合器,也可自定义聚合器以接收少样本数据。

- 灵活响应格式化:使用

output_format解析模型输出信息并存储在AgentMessage的formatted字段。 - 工具调用一致性:

ActionExecutor与智能体使用相同通信数据结构,支持自定义消息转换钩子。 - 双接口设计:提供同步和异步接口,可根据需求选择以充分利用资源。

技术原理

- 基于大语言模型(如VllmModel、INTERNLM2_META等),通过

Agent类封装模型调用逻辑。 - 利用

AgentMessage作为消息传递的数据结构,在智能体的__call__方法中处理消息,包括添加记忆、调用模型和应用钩子等操作。 - 借助

ActionExecutor执行工具调用,使用Hook类实现消息转换和处理的自定义逻辑。

应用场景

-

数学问题解决:通过编程解决数学问题,如使用

Coder智能体。 -

博客写作:异步博客智能体通过自我完善提高写作质量。

-

信息检索与数据可视化:执行信息检索、数据收集和图表绘制等多智能体工作流。

-

InternLM/lagent: A lightweight framework for building LLM-based agents

3.toolkam-Agent

简介

Toolkami 是由 aperoc 在 GitHub 上开发的一个开源、轻量级人工智能代理框架。其核心理念是极简主义,仅通过七个基本工具即可构建功能齐全的 AI 代理。该框架旨在提供强大而简单的功能,实现以最小的复杂性提供最大的功能。

核心功能

Toolkami 的核心功能围绕其七个关键工具展开,旨在使 AI 代理能够执行多样的任务并进行自我改进:

- Read (读取):允许代理读取信息。

- Write Diff (写入差异):支持代理修改内容,并记录修改轨迹。

- Browse (浏览):使代理能够访问和导航网络信息。

- Command (命令):执行命令行操作,与系统进行交互。

- Ask (提问):允许代理向用户或其他模块提问以获取信息或澄清。

- Think (思考):支持代理进行内部推理和决策。 此外,框架还提供 Turbo mode(涡轮模式) 实现无人工干预的自动化操作,以及 Hot-reloading(热重载) 实现代理的自修改能力。

技术原理

Toolkami 的技术原理在于其精炼的工具集设计和自适应机制。

- 模块化工具集: 框架将复杂任务分解为七个原子操作(Read, Write Diff, Browse, Command, Ask, Think),通过这些工具的组合与协作来完成高级代理行为。这种模块化设计降低了系统复杂性,提升了可维护性。

- “Turbo mode”: 实现代理的自主运行和决策,减少人工干预,可能通过预设规则、强化学习或目标导向规划等方式实现代理的自动化行为。

- “Hot-reloading”: 允许代理在运行时进行自我代码或逻辑的修改和更新,无需重启。这通常涉及到动态代码加载、反射机制或元编程技术,使代理能够基于环境反馈或自身学习结果进行适应性进化。

- 轻量级架构: 强调最小化依赖和资源占用,以提高运行效率和部署便捷性,适合在资源受限的环境中运行。

应用场景

Toolkami 的极简和高效特性使其适用于多种 AI 代理开发和自动化场景:

- 自动化任务处理: 构建能够自主执行文件操作、网络浏览、数据读写等日常或复杂自动化任务的代理。

- 开发辅助工具: 作为开发人员的智能助手,自动完成代码修改、文档生成或环境配置等工作。

- 教育和研究: 为 AI 代理原理的教学和研究提供一个简单易懂、功能完整的实验平台。

- 轻量级智能系统: 部署于资源有限的边缘设备或嵌入式系统中,实现基本的智能化控制和响应。

- 快速原型开发: 帮助开发者快速构建和测试 AI 代理的原型,验证想法。

3.斯坦福小镇generative_agents

简介

该项目围绕论文“Generative Agents: Interactive Simulacra of Human Behavior”展开,包含生成式智能体的核心模拟模块及其游戏环境,可在本地机器上设置模拟环境并进行模拟演示。

核心功能

- 模拟运行:可启动环境服务器和智能体模拟服务器,运行多智能体模拟,能控制模拟步数,保存和继续模拟。

- 模拟回放:可对已运行的模拟进行回放,还能压缩模拟文件进行演示。

- 模拟定制:可通过初始化智能体历史或创建新的基础模拟文件来定制模拟。

技术原理

借助OpenAI API,结合Python环境运行Django项目实现环境服务器和模拟服务器的启动与交互,通过文件存储模拟数据。

应用场景

-

学术研究:用于研究人类行为模拟、人机交互等领域。

-

游戏开发:为游戏提供更真实的智能体行为模拟。

-

joonspk-research/generative_agents: Generative Agents: Interactive Simulacra of Human Behavior

4.MobileAgent具身机器人

简介

Mobile-Agent-v2是用于解决长上下文图文交错输入中导航问题的移动设备操作助手,通过多智能体协作实现有效导航。它增强了视觉感知模块,凭借GPT - 4o提升操作性能和速度,已被NeurIPS 2024接收,还发布了可上传手机截图体验的Demo。

核心功能

- 解决长上下文图文交错输入中的导航问题。

- 通过多智能体协作实现移动设备操作的有效导航。

- 增强视觉感知模块,提升操作准确率。

- 利用GPT - 4o提升操作性能和速度。

技术原理

采用多智能体架构,结合增强的视觉感知模块,借助GPT - 4o进行运算。可根据设备性能选择不同的图标描述模型调用方法和具体模型,如本地部署或API调用,使用不同的Qwen系列模型,还可设置“反思智能体”和“内存单元”开关。

应用场景

适用于安卓和鸿蒙系统(版本号 <= 4)的移动设备操作辅助,如用户在移动设备上进行复杂操作时,可借助该助手更高效准确地完成任务。

4.UFO-微软面向Windows的Agent框架

简介

UFO²是微软开源的桌面代理操作系统(Desktop AgentOS),可将自然语言请求转化为跨应用工作流,在Windows系统上运行。它具有深度操作系统集成、多模式控制检测等关键能力,2025年4月发布v2.0.0版本,引入AgentOS概念。

核心功能

- 任务执行:将自然语言目标解析为操作步骤,协调应用程序完成任务。

- 多模式控制:结合Windows UIA、Win32和WinCOM进行控件检测,选择GUI操作或原生API执行。

- 知识融合:融合离线文档、在线搜索、演示和执行跟踪等知识,支持检索增强生成。

- 推测执行:预测批量操作并一次性验证,减少大语言模型查询次数。

- 隔离运行:即将支持在隔离的虚拟桌面运行,不影响主工作区。

技术原理

UFO²采用多代理框架,包括HostAgent、AppAgents、Knowledge Substrate、Speculative Executor等组件。HostAgent负责解析目标和协调AppAgents;AppAgents通过多模态感知和混合控制检测选择执行方式;Knowledge Substrate将各类知识整合到向量存储中;Speculative Executor预测并验证批量操作以降低延迟。

应用场景

-

办公自动化:在Office、Edge等应用中自动完成文档处理、网页浏览等任务。

-

系统管理:执行文件管理、系统设置等操作。

-

跨应用协作:协调多个应用完成复杂任务,如数据导入导出、报告生成等。

-

microsoft/UFO: A UI-Focused Agent for Windows OS Interaction.

DeepSWE-Agent框架

简介

DeepSWE-Preview 是 Agentica Project 开源的一个先进的软件工程(SWE)智能体模型,专注于代码的理解、修改与优化。它是 rLLM 框架下通过强化学习进行训练的代表性成果。rLLM 是一个旨在通过大规模复现先进强化学习技术来推动大型语言模型(LLMs)强化学习民主化的开源框架,致力于构建通用且可扩展的智能体系统。

核心功能

- 自动化代码操作: DeepSWE-Preview 能够自动理解和编辑代码,包括快速定位并修复漏洞、优化性能瓶颈以及重构代码结构。

- 软件工程任务执行: 作为软件工程智能体,它在 SWEBench-Verified 等基准测试上表现出色,能够处理复杂的软件开发任务。

- 语言智能体训练与部署: rLLM 框架提供构建自定义智能体和环境、利用强化学习进行训练以及将其部署到实际工作负载的能力。

- 代码生成与推理: 除了软件工程,Agentica Project 还通过如 DeepCoder-14B-Preview 等模型,实现了高精度的代码生成与推理功能。

技术原理

DeepSWE-Preview 的核心技术原理是基于强化学习(RL)对大型语言模型进行后训练(post-training)。具体而言,它采用纯粹的强化学习方法进行训练,以解决复杂的软件工程问题。rLLM 框架则致力于民主化强化学习技术,通过**分布式强化学习(Distributed RL)**的方法,实现对 LLMs 的大规模微调和行为塑造,从而提升智能体在特定任务上的表现。这包括构建 reward function、设计环境交互机制以及优化训练策略,使模型能够从经验中学习并改进其代码理解和生成能力。

应用场景

- 自动化软件开发: 用于自动化代码漏洞修复、性能优化、代码重构和维护等任务,显著提升软件开发效率和代码质量。

- 智能编程辅助: 为开发者提供智能代码补全、错误检测和修复建议,作为高级编程助手。

- 教育与研究: 为学术界和研究人员提供一个开源框架,用于探索和开发基于强化学习的语言智能体。

- 企业级解决方案: 在大型企业中应用于代码库管理、自动化测试、CI/CD流程中的智能代码审查等。

deepagent

简介

DeepAgent 是 Abacus.AI 推出的一款通用型人工智能助理,旨在自动化和简化复杂的工作流程。它能够结合高级研究能力与实际执行,从生成定制应用、报告、演示文稿到自动化跨平台(如 Google Workspace 和 Jira)的任务,全面提升工作效率。

核心功能

- 多任务自动化: 自动化处理多种复杂任务和工作流程。

- 内容生成: 自动创建应用程序、视频、演示文稿、网站,甚至小型游戏(如数独)。

- 文档分析与提取: 分析上传的合同,自动提取关键条款、条款和条件,简化合同审查。

- 平台集成: 支持与 Google Workspace 和 Jira 等现有平台的无缝集成。

- AI 应用构建: 能够根据需求构建特定功能的 AI 应用程序。

技术原理

DeepAgent 的技术核心在于其作为“通用代理”的能力,这表明它可能融合了多模态学习、自然语言处理(NLP)和强化学习等先进AI技术。通过对大量数据的训练,它能够理解用户意图、规划执行路径,并调用相应的模块或API来完成任务。其自动化能力可能依赖于预设的工作流模板和动态任务编排,使得AI能够像人类一样进行研究、分析和内容创造。具体而言,合同分析功能可能利用了信息提取(Information Extraction)和命名实体识别(Named Entity Recognition, NER)等NLP技术,而内容生成则可能基于大型语言模型(LLM)和生成对抗网络(GAN)等生成式AI模型。

应用场景

- 企业自动化: 自动化日常办公任务、数据报告生成和流程审批。

- 合同管理: 法律和金融领域中,快速审查、分析和提取合同关键信息。

- 市场营销与内容创作: 自动生成营销文案、网站内容、演示幻灯片和宣传视频。

- 软件开发与应用构建: 快速构建和部署特定功能的AI应用程序,无需深入编程知识。

- 项目管理: 自动化Jira等项目管理工具中的任务分配、进度更新和报告。

- 教育与培训: 自动生成教学材料、测验和交互式学习内容。

RoboBrain 2.0 – 智谱

简介

RoboBrain 2.0是由北京智源人工智能研究院(BAAI)开发的开源具身视觉语言基础模型,旨在统一物理环境中复杂具身任务的感知、推理与规划能力。模型包含轻量级7B和全尺寸32B两种变体,采用异构架构(视觉编码器+语言模型),在空间推理(如可达性预测、空间指称)和时间决策(如闭环交互、多智能体长程规划)等任务中表现优异,超越多数开源及专有模型,是当前最强大的开源具身智能模型之一。

核心功能

- 空间理解:支持精确的空间指称(点、边界框预测)、可达性预测(如抓取杯子的手柄)、轨迹预测及场景推理(实时场景图构建与更新)。

- 时间决策:具备长程规划与闭环反馈能力,支持多智能体长程协作任务(如超市补货、餐厅服务)及实时场景记忆更新。

- 多模态处理:支持多图像、长视频、高分辨率视觉输入,结合复杂任务指令与结构化场景图,输出结构化计划、空间关系及绝对/相对坐标。

- 推理与规划:通过思维链(CoT)推理生成多步决策轨迹,支持任务分解与动态环境适应(如中断调整、场景快速适配)。

技术原理

- 模型架构:采用模块化编解码架构,包含视觉编码器(处理高分辨率图像/视频)、MLP投影器(映射视觉特征至语言模型空间)及解码器(语言模型,支持长链推理)。视觉输入经编码器处理后与文本输入统一为多模态令牌流,由解码器生成结构化输出(如坐标、计划)。

- 训练数据:覆盖通用多模态(VQA、视觉对话)、空间(视觉定位、指称、可达性)及时间(自我视角规划、多机器人协作)三类数据,通过合成与标注构建大规模高质量数据集(如空间数据合成流水线、多机器人协作模板)。

- 训练策略:分三阶段训练:基础时空学习(通用感知与理解)、具身时空增强(多视角/视频数据强化长程依赖)、具身场景思维链推理(监督微调+强化微调,提升因果推理能力)。

- 基础设施:基于FlagScale(分布式训练框架)和FlagEvalMM(多模态评估框架),支持混合并行训练、内存预分配及故障恢复,优化训练与推理效率。

应用场景

- 机器人操作:如物体抓取(定位手柄)、室内导航(识别空闲区域)、桌面操作(物体排列)等。

- 多机器人协作:家庭、超市、餐厅场景下的任务分解与协同(如补货、送餐、礼品包装)。

- 实时交互:支持语音中断调整、动态场景适配(如识别物体距离/方向)及闭环任务执行(如咖啡机操作)。

- 智能规划:长程任务分解(如准备咖啡、烹饪)、多步骤空间指称(如“将杯子放在笔架和键盘之间”)及轨迹生成(如机器人手臂移动路径)。

- 项目官网:https://superrobobrain.github.io/

- GitHub仓库:https://github.com/FlagOpen/RoboBrain2.0

- HuggingFace模型库:https://huggingface.co/collections/BAAI/robobrain20-6841eeb1df55c207a4ea0036

- arXiv技术论文:https://arxiv.org/pdf/2507.02029

RoboOS 2.0 – 智谱

简介

RoboOS是首个开源具身操作系统,基于大脑-小脑分层架构,旨在解决多智能体协作中跨实体适应性差、任务调度低效及动态纠错不足等问题。其核心通过具身大脑模型(多模态大语言模型)、小脑技能库(模块化即插即用工具包)和实时共享内存(时空同步机制)的协同,支持长程任务的规划、调度与纠错,以及多智能体高效协作,并优化了边缘-云通信与分布式推理,适用于餐厅、家庭、超市等多场景的异构实体协作。

核心功能

- 全局感知与决策:具身大脑模型(如RoboBrain)通过多模态大语言模型实现全局场景感知(3D重建、历史状态追踪)、多智能体任务分解及轨迹生成,支持动态纠错与实时重规划。

- 模块化技能执行:小脑技能库提供操作(VLA/专家工具)、导航(VLN/SLAM)及特殊技能(接触交互、可变形物体处理)的模块化工具,适配单臂、双臂、人形等异构实体。

- 多智能体状态同步:实时共享内存通过空间记忆(动态场景图)、时间记忆(任务反馈、工具调用日志)和机器人记忆(运动约束、电池状态),实现多智能体的时空协同与负载均衡。

- 可扩展部署:基于FlagScale框架优化边缘-云通信与分布式推理,支持高频交互与大规模云推理。

技术原理

RoboOS采用大脑-小脑分层架构:

- 具身大脑模型:以多模态大语言模型(如RoboBrain)为核心,通过三阶段训练(通用VLM、机器人专项、系统增强)强化多智能体任务规划、工具调用及记忆更新能力,结合检索增强生成(RAG)融合场景、任务、机器人状态等信息生成子任务图。

- 小脑技能库:标准化工具与机器人配置文件实现异构实体的即插即用,支持操作(如抓握)、导航(如SLAM)及特殊技能(如灵巧手控制)的低延迟执行。

- 实时共享内存:空间记忆通过多视角RGB-D输入构建场景图(楼层-房间-物体分层节点);时间记忆记录任务历史;机器人记忆存储实时状态,三者协同支持任务分配与动态调整。

- 边缘-云通信:基于FlagScale框架,采用发布-订阅机制实现低延迟(<0.001s)指令响应,结合内存优化数据引擎支持TB级历史数据访问,并行推理与多任务调度提升系统扩展性。

应用场景

- 服务机器人:餐厅场景中,人形与双臂机器人协作完成汉堡制作与配送;家庭场景中,单臂与双臂机器人协同取递水果、刀具。

- 零售与仓储:超市场景下,机器人协作完成礼品挑选、包装及货架补货。

- 工业自动化:支持多类型工业机器人(如机械臂、轮式平台)在装配线中的任务分解与协同执行。

- 智能制造:通过多智能体协作优化生产流程,实现动态任务调度与错误纠正。

- 项目官网:https://github.com/FlagOpen/RoboOS

- GitHub仓库:https://github.com/FlagOpen/RoboOS

- arXiv技术论文:https://arxiv.org/pdf/2505.03673

- github地址:AI-Compass👈:https://github.com/tingaicompass/AI-Compass

- gitee地址:AI-Compass👈:https://gitee.com/tingaicompass/ai-compass

🌟 如果本项目对您有所帮助,请为我们点亮一颗星!🌟