【目标检测】YOLOv3

论文

YOLO v3

网络结构

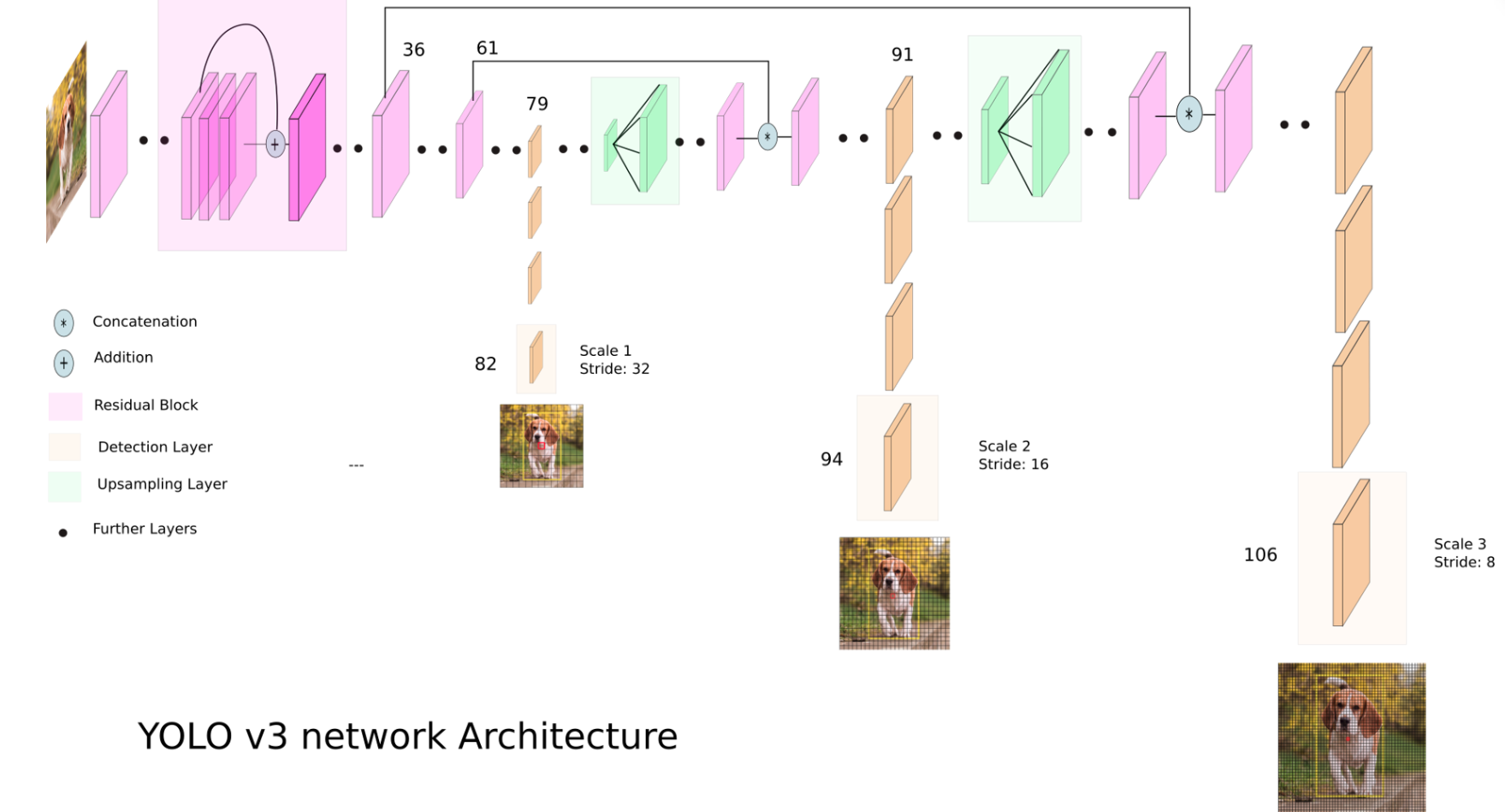

YOLOv3加深了网络,卷积的层数达到了106层。相较于之前的版本,最大的变化在于使用不同尺度的特征图进行检测。网络结构如图所示:

图来源:https://towardsdatascience.com/yolo-v3-object-detection-53fb7d3bfe6b

- 在82层卷积处输出第一个检测结果。假设图片的输入大小为416×416,此时特征图的大小为13×13。每一个cell设置3个anchor,每一个anchor预测(4+1+C)个值,假设类别为60类,那么共计输出3×(4+1+60)=255个值,即输出维度为13×13×255。

- 第79层的卷积的输出结果继续进行卷积操作,上采样,和浅层特征融合,卷积,得到第二种尺寸的检测输出。输出维度为26×26×255

- 后面进行与第二步类似的操作,输出维度为52×52×255

在YOLOv3中,预设的anchor个数共有 (13∗13+26∗26∗52∗52)∗3=10647;YOLOv2***有 13∗13∗5=845。

每一种scale中预设的anchor是从数据集中聚类得到的9种中的三种。

使用不同尺度的特征图来预测,改善了YOLO对小物体的检测效果。

类别预测

将softmax预测换成了二分类的多标签预测,因为在一些数据集中,例如有些框体可以同时有Woman和Person这两个标签。